Comment détecter un Arbre de Noël?

Quelles techniques de traitement d'image pourrait-on utiliser pour mettre en œuvre une application qui détecte les arbres de Noël affichés dans les images suivantes?

je suis à la recherche de solutions qui vont fonctionner sur toutes ces images. Par conséquent, les approches qui nécessitent une formation haar cascade classificateurs ou template matching ne sont pas très intéressants.

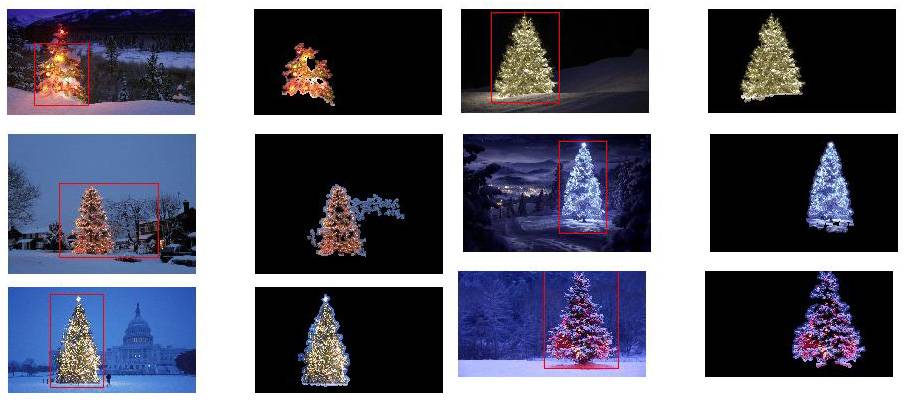

je cherche quelque chose qui peut être écrit dans n'importe quel langage de programmation, aussi longtemps que il utilise seulement Open Source technologies. La solution doit être testée avec les images qui sont partagées sur cette question. Il y a 6 entrées images et la réponse doit afficher les résultats du traitement de chacun d'eux. Enfin, pour chaque image de sortie il doit y avoir lignes rouges dessiner pour entourer l'arbre détecté.

comment vous y prendriez-vous pour détecter les arbres dans ces images?

10 réponses

j'ai une approche qui me semble intéressante et un peu différente des autres. La principale différence dans mon approche, par rapport à certaines autres, est dans la façon dont l'étape de segmentation de l'image est effectuée--j'ai utilisé l'algorithme de regroupement DBSCAN de scikit-learn de Python; il est optimisé pour trouver des formes quelque peu amorphes qui ne peuvent pas nécessairement avoir un seul centroïde clair.

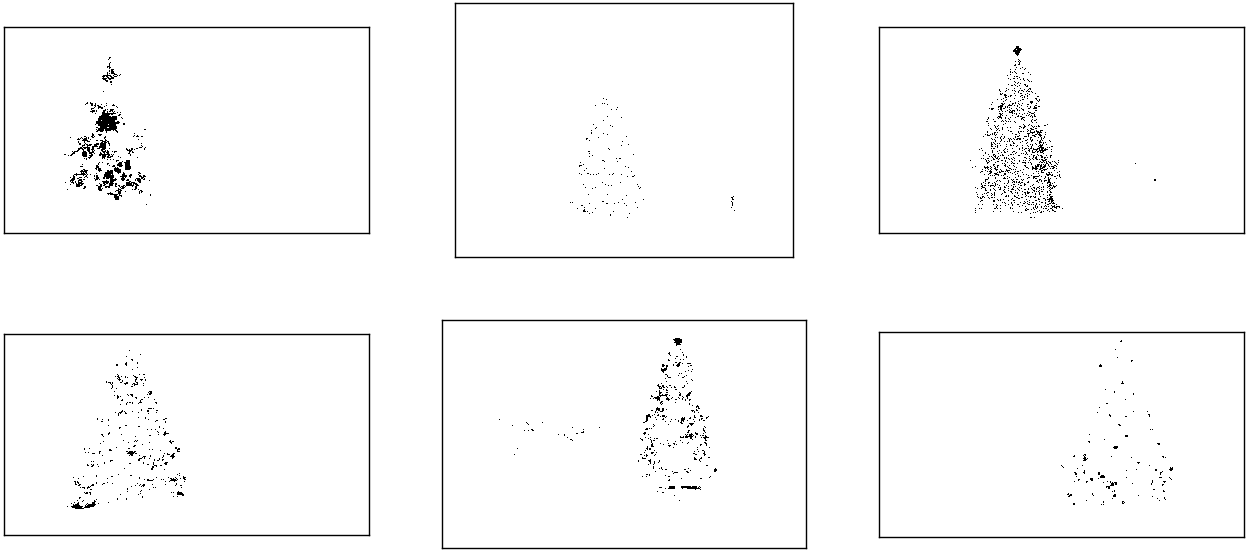

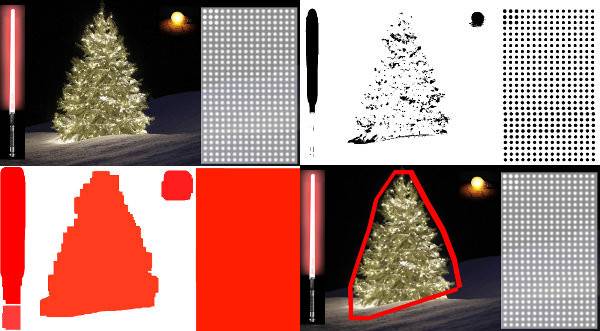

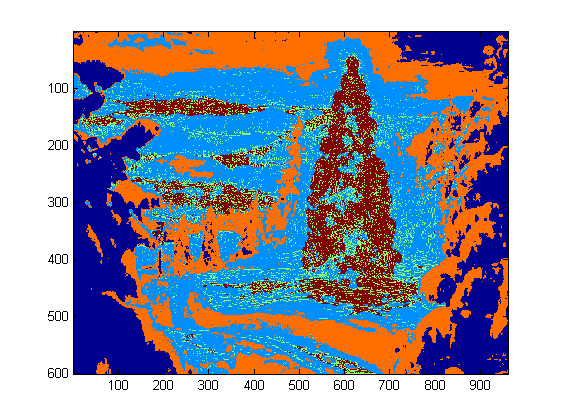

au niveau supérieur, mon approche est assez simple et peut être décomposée en 3 étapes. D'abord j'applique un seuil (ou en fait, le "ou" logique des deux distincts et séparés des seuils). Comme avec beaucoup d'autres réponses, j'ai supposé que L'arbre de Noël serait l'un des objets les plus lumineux de la scène, donc le premier seuil est juste un simple test de luminosité monochrome; tous les pixels avec des valeurs supérieures à 220 sur une échelle 0-255 (où le noir est 0 et le blanc est 255) sont enregistrés à une image binaire en noir et blanc. Le second seuil tente de chercher des feux rouges et jaunes, particulièrement visibles dans les arbres de la partie supérieure gauche et de la partie inférieure droite des six images, se détachent bien sur le fond bleu-vert qui prédomine sur la plupart des photos. Je convertis l'image RVB en espace hsv, et exige que la teinte soit inférieure à 0.2 sur une échelle de 0.0-1.0 (correspondant grossièrement à la frontière entre le jaune et le vert) ou supérieure à 0.95 (correspondant à la frontière entre le violet et le rouge) et en outre je nécessite lumineux, couleurs saturées: la saturation et la valeur doivent toutes deux être supérieures à 0,7. Les résultats des deux procédures de seuil sont logiquement "ou"-ed ensemble, et la matrice résultante d'images binaires en noir et blanc est montrée ci-dessous:

vous pouvez clairement voir que chaque image a un grand faisceau de pixels correspondant approximativement à l'emplacement de chaque arbre, plus quelques-unes des images ont également quelques autres petits faisceaux correspondant soit pour éclairer les fenêtres de certains des bâtiments, ou à une scène de fond à l'horizon. L'étape suivante consiste à amener l'ordinateur à reconnaître qu'il s'agit de clusters séparés, et à étiqueter chaque pixel correctement avec un numéro d'identification d'appartenance de cluster.

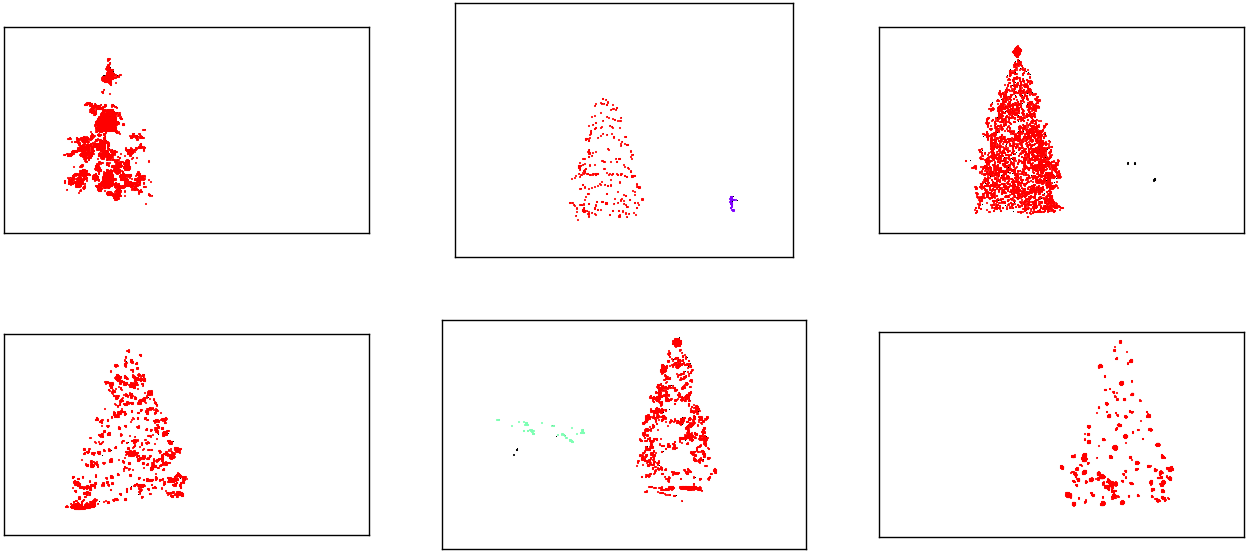

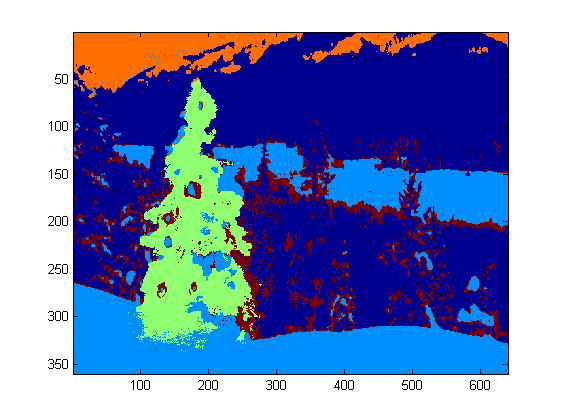

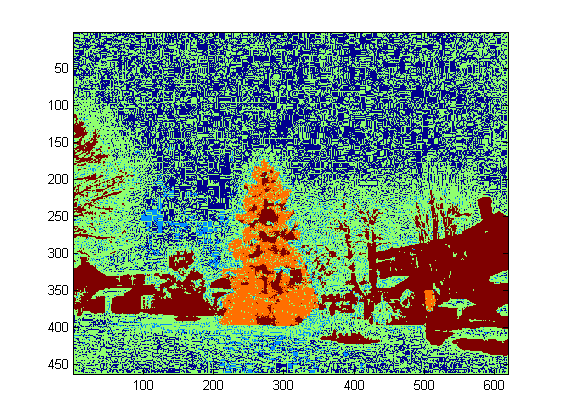

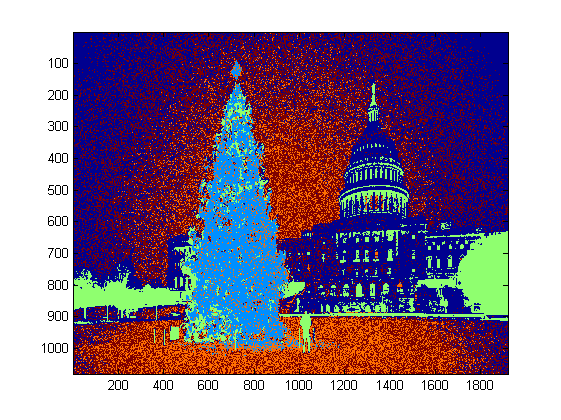

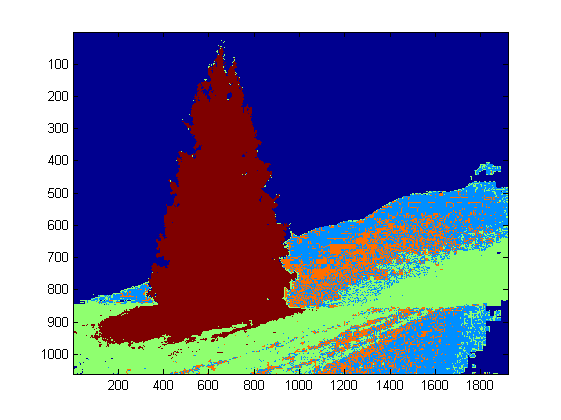

pour cette tâche j'ai choisi DBSCAN . Il y a une assez bonne comparaison visuelle de la façon dont DBSCAN se comporte typiquement, par rapport à d'autres algorithmes de regroupement, disponible ici . Comme je l'ai dit plus tôt, il fait bien avec les formes amorphes. La sortie de DBSCAN, avec chaque grappe tracée dans une couleur différente, est montrée ici:

il y a plusieurs choses dont il faut être conscient quand on regarde ce résultat. Tout d'abord, DBSCAN demande à l'utilisateur de définir un paramètre "proximité" afin de réguler son comportement, qui contrôle effectivement comment une paire de points doit être séparée pour que l'algorithme déclare un nouveau séparer l'amas plutôt que d'agglomérer un point d'essai sur un amas préexistant. J'ai mis cette valeur de 0,04 fois la taille le long de la diagonale de chaque image. Comme la taille des images varie d'environ VGA à environ HD 1080, ce type de définition relative à l'échelle est critique.

un autre point à noter est que L'algorithme DBSCAN tel qu'il est implémenté dans scikit-learn a des limites de mémoire qui sont assez difficiles pour certaines des plus grandes images dans ce échantillon. Par conséquent, pour quelques-unes des plus grandes images, j'ai en fait dû "décimer" (c'est-à-dire Ne conserver que tous les 3 ou 4 pixels et laisser tomber les autres) chaque groupe afin de rester à l'intérieur de cette limite. En raison de ce processus d'élimination, les pixels épars restants sont difficiles à voir sur certaines des plus grandes images. Par conséquent, pour les besoins de l'Affichage Seulement, les pixels de couleur codés dans les images ci-dessus ont été effectivement "dilatés" juste légèrement pour qu'ils ressortent mieux. C'est purement une opération esthétique pour le plaisir de la narration; bien qu'il y ait des commentaires mentionnant cette dilatation dans mon code, soyez assuré que cela n'a rien à voir avec des calculs qui ont réellement de l'importance.

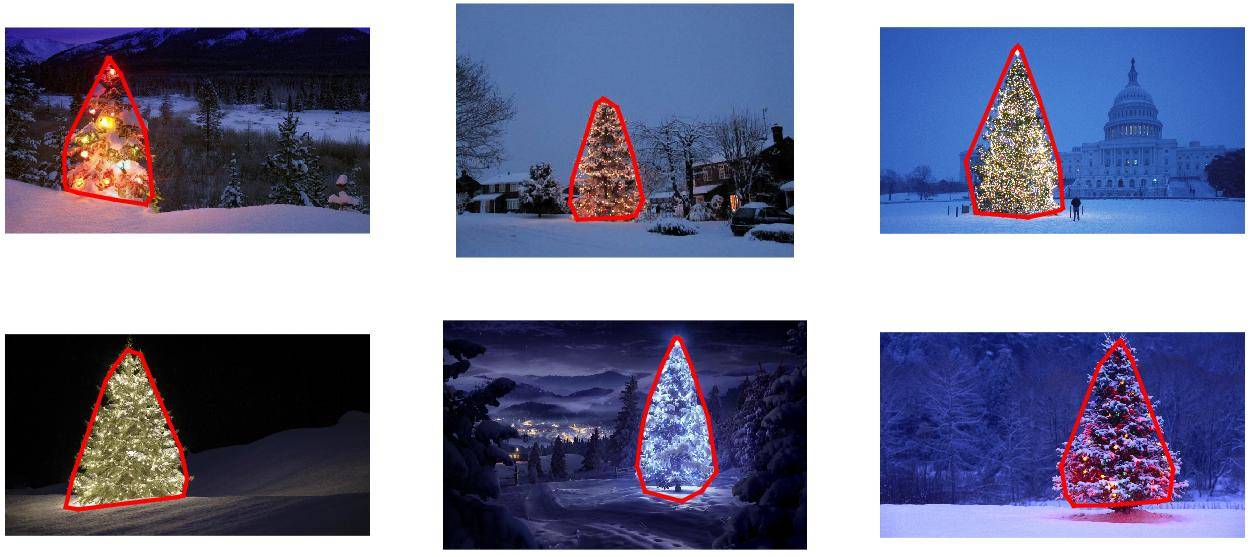

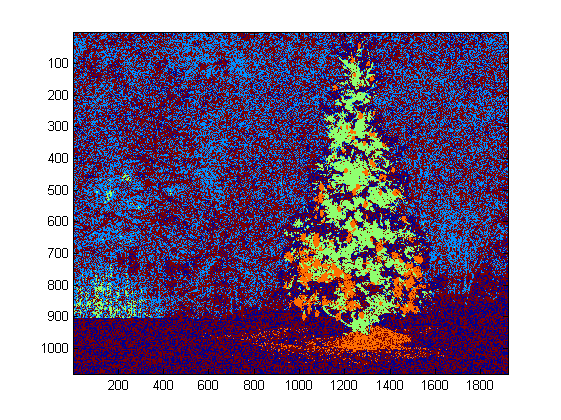

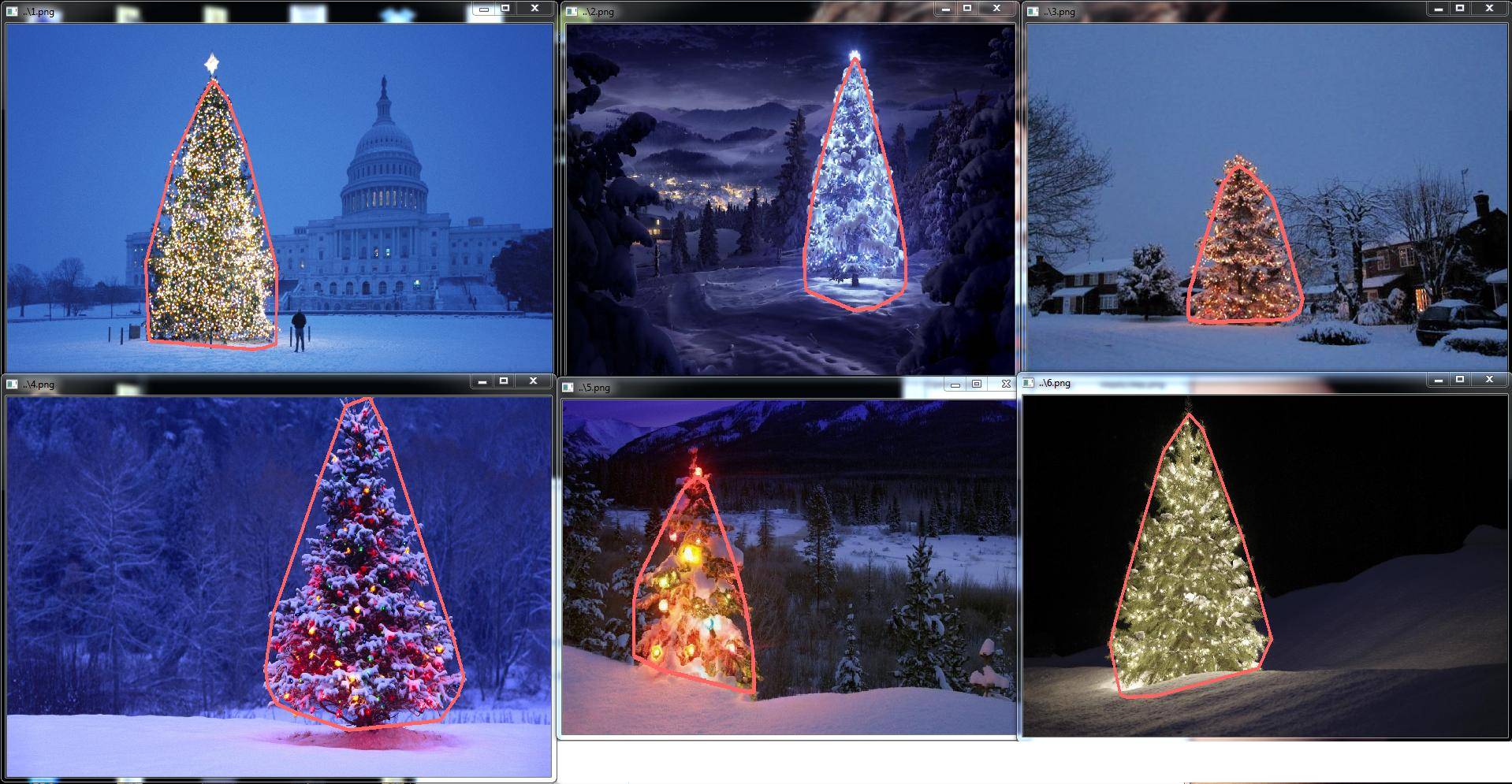

une fois que les clusters sont identifiés et étiquetés, la troisième et dernière étape est facile: je prends simplement le plus grand cluster dans chaque image (dans ce cas, j'ai choisi de mesurer la "taille" en termes du nombre total de pixels membres, bien qu'on aurait pu tout aussi facilement type de métrique qui mesure l'étendue physique) et calcule la coque convexe pour cet amas. La coque convexe devient alors la bordure de l'arbre. Les six Coques convexes calculées par cette méthode sont indiquées ci-dessous en rouge:

le code source est écrit pour Python 2.7.6 et il dépend de numpy , scipy , matplotlib et scikit-learn . J'ai divisé en deux parties. La première partie est responsable du traitement d'image proprement dit:

from PIL import Image

import numpy as np

import scipy as sp

import matplotlib.colors as colors

from sklearn.cluster import DBSCAN

from math import ceil, sqrt

"""

Inputs:

rgbimg: [M,N,3] numpy array containing (uint, 0-255) color image

hueleftthr: Scalar constant to select maximum allowed hue in the

yellow-green region

huerightthr: Scalar constant to select minimum allowed hue in the

blue-purple region

satthr: Scalar constant to select minimum allowed saturation

valthr: Scalar constant to select minimum allowed value

monothr: Scalar constant to select minimum allowed monochrome

brightness

maxpoints: Scalar constant maximum number of pixels to forward to

the DBSCAN clustering algorithm

proxthresh: Proximity threshold to use for DBSCAN, as a fraction of

the diagonal size of the image

Outputs:

borderseg: [K,2,2] Nested list containing K pairs of x- and y- pixel

values for drawing the tree border

X: [P,2] List of pixels that passed the threshold step

labels: [Q,2] List of cluster labels for points in Xslice (see

below)

Xslice: [Q,2] Reduced list of pixels to be passed to DBSCAN

"""

def findtree(rgbimg, hueleftthr=0.2, huerightthr=0.95, satthr=0.7,

valthr=0.7, monothr=220, maxpoints=5000, proxthresh=0.04):

# Convert rgb image to monochrome for

gryimg = np.asarray(Image.fromarray(rgbimg).convert('L'))

# Convert rgb image (uint, 0-255) to hsv (float, 0.0-1.0)

hsvimg = colors.rgb_to_hsv(rgbimg.astype(float)/255)

# Initialize binary thresholded image

binimg = np.zeros((rgbimg.shape[0], rgbimg.shape[1]))

# Find pixels with hue<0.2 or hue>0.95 (red or yellow) and saturation/value

# both greater than 0.7 (saturated and bright)--tends to coincide with

# ornamental lights on trees in some of the images

boolidx = np.logical_and(

np.logical_and(

np.logical_or((hsvimg[:,:,0] < hueleftthr),

(hsvimg[:,:,0] > huerightthr)),

(hsvimg[:,:,1] > satthr)),

(hsvimg[:,:,2] > valthr))

# Find pixels that meet hsv criterion

binimg[np.where(boolidx)] = 255

# Add pixels that meet grayscale brightness criterion

binimg[np.where(gryimg > monothr)] = 255

# Prepare thresholded points for DBSCAN clustering algorithm

X = np.transpose(np.where(binimg == 255))

Xslice = X

nsample = len(Xslice)

if nsample > maxpoints:

# Make sure number of points does not exceed DBSCAN maximum capacity

Xslice = X[range(0,nsample,int(ceil(float(nsample)/maxpoints)))]

# Translate DBSCAN proximity threshold to units of pixels and run DBSCAN

pixproxthr = proxthresh * sqrt(binimg.shape[0]**2 + binimg.shape[1]**2)

db = DBSCAN(eps=pixproxthr, min_samples=10).fit(Xslice)

labels = db.labels_.astype(int)

# Find the largest cluster (i.e., with most points) and obtain convex hull

unique_labels = set(labels)

maxclustpt = 0

for k in unique_labels:

class_members = [index[0] for index in np.argwhere(labels == k)]

if len(class_members) > maxclustpt:

points = Xslice[class_members]

hull = sp.spatial.ConvexHull(points)

maxclustpt = len(class_members)

borderseg = [[points[simplex,0], points[simplex,1]] for simplex

in hull.simplices]

return borderseg, X, labels, Xslice

et la seconde partie est un script au niveau de l'utilisateur qui appelle le premier fichier et génère tous les tracés ci-dessus:

#!/usr/bin/env python

from PIL import Image

import numpy as np

import matplotlib.pyplot as plt

import matplotlib.cm as cm

from findtree import findtree

# Image files to process

fname = ['nmzwj.png', 'aVZhC.png', '2K9EF.png',

'YowlH.png', '2y4o5.png', 'FWhSP.png']

# Initialize figures

fgsz = (16,7)

figthresh = plt.figure(figsize=fgsz, facecolor='w')

figclust = plt.figure(figsize=fgsz, facecolor='w')

figcltwo = plt.figure(figsize=fgsz, facecolor='w')

figborder = plt.figure(figsize=fgsz, facecolor='w')

figthresh.canvas.set_window_title('Thresholded HSV and Monochrome Brightness')

figclust.canvas.set_window_title('DBSCAN Clusters (Raw Pixel Output)')

figcltwo.canvas.set_window_title('DBSCAN Clusters (Slightly Dilated for Display)')

figborder.canvas.set_window_title('Trees with Borders')

for ii, name in zip(range(len(fname)), fname):

# Open the file and convert to rgb image

rgbimg = np.asarray(Image.open(name))

# Get the tree borders as well as a bunch of other intermediate values

# that will be used to illustrate how the algorithm works

borderseg, X, labels, Xslice = findtree(rgbimg)

# Display thresholded images

axthresh = figthresh.add_subplot(2,3,ii+1)

axthresh.set_xticks([])

axthresh.set_yticks([])

binimg = np.zeros((rgbimg.shape[0], rgbimg.shape[1]))

for v, h in X:

binimg[v,h] = 255

axthresh.imshow(binimg, interpolation='nearest', cmap='Greys')

# Display color-coded clusters

axclust = figclust.add_subplot(2,3,ii+1) # Raw version

axclust.set_xticks([])

axclust.set_yticks([])

axcltwo = figcltwo.add_subplot(2,3,ii+1) # Dilated slightly for display only

axcltwo.set_xticks([])

axcltwo.set_yticks([])

axcltwo.imshow(binimg, interpolation='nearest', cmap='Greys')

clustimg = np.ones(rgbimg.shape)

unique_labels = set(labels)

# Generate a unique color for each cluster

plcol = cm.rainbow_r(np.linspace(0, 1, len(unique_labels)))

for lbl, pix in zip(labels, Xslice):

for col, unqlbl in zip(plcol, unique_labels):

if lbl == unqlbl:

# Cluster label of -1 indicates no cluster membership;

# override default color with black

if lbl == -1:

col = [0.0, 0.0, 0.0, 1.0]

# Raw version

for ij in range(3):

clustimg[pix[0],pix[1],ij] = col[ij]

# Dilated just for display

axcltwo.plot(pix[1], pix[0], 'o', markerfacecolor=col,

markersize=1, markeredgecolor=col)

axclust.imshow(clustimg)

axcltwo.set_xlim(0, binimg.shape[1]-1)

axcltwo.set_ylim(binimg.shape[0], -1)

# Plot original images with read borders around the trees

axborder = figborder.add_subplot(2,3,ii+1)

axborder.set_axis_off()

axborder.imshow(rgbimg, interpolation='nearest')

for vseg, hseg in borderseg:

axborder.plot(hseg, vseg, 'r-', lw=3)

axborder.set_xlim(0, binimg.shape[1]-1)

axborder.set_ylim(binimg.shape[0], -1)

plt.show()

EDIT NOTE: j'ai édité ce post pour (i) traiter chaque image d'arbre individuellement, comme demandé dans les exigences, (ii) considérer à la fois la luminosité et la forme de l'objet afin d'améliorer la qualité du résultat.

ci-dessous est présenté une approche qui prend en considération la luminosité et la forme de l'objet. En d'autres termes, il cherche des objets ayant une forme triangulaire et une luminosité significative. Il a été implémenté en Java, en utilisant Marvin image processing framework.

la première étape est le seuil de couleur. L'objectif ici est de focaliser l'analyse sur des objets avec une luminosité significative.

images de sortie:

http://marvinproject.sourceforge.net/other/trees/tree_1threshold.png http://marvinproject.sourceforge.net/other/trees/tree_2threshold.png http://marvinproject.sourceforge.net/other/trees/tree_3threshold.png

http://marvinproject.sourceforge.net/other/trees/tree_4threshold.png http://marvinproject.sourceforge.net/other/trees/tree_5threshold.png http://marvinproject.sourceforge.net/other/trees/tree_6threshold.png

code source:

public class ChristmasTree {

private MarvinImagePlugin fill = MarvinPluginLoader.loadImagePlugin("org.marvinproject.image.fill.boundaryFill");

private MarvinImagePlugin threshold = MarvinPluginLoader.loadImagePlugin("org.marvinproject.image.color.thresholding");

private MarvinImagePlugin invert = MarvinPluginLoader.loadImagePlugin("org.marvinproject.image.color.invert");

private MarvinImagePlugin dilation = MarvinPluginLoader.loadImagePlugin("org.marvinproject.image.morphological.dilation");

public ChristmasTree(){

MarvinImage tree;

// Iterate each image

for(int i=1; i<=6; i++){

tree = MarvinImageIO.loadImage("./res/trees/tree"+i+".png");

// 1. Threshold

threshold.setAttribute("threshold", 200);

threshold.process(tree.clone(), tree);

}

}

public static void main(String[] args) {

new ChristmasTree();

}

}

dans la deuxième étape, les points les plus brillants de l'image sont dilatés afin de former des formes. Le résultat de ce processus est la forme probable des objets avec une luminosité significative. En appliquant la segmentation de remplissage par inondation, les formes déconnectées sont détectées.

images de sortie:

http://marvinproject.sourceforge.net/other/trees/tree_1_fill.png http://marvinproject.sourceforge.net/other/trees/tree_2_fill.png http://marvinproject.sourceforge.net/other/trees/tree_3_fill.png

http://marvinproject.sourceforge.net/other/trees/tree_4_fill.png http://marvinproject.sourceforge.net/other/trees/tree_5_fill.png http://marvinproject.sourceforge.net/other/trees/tree_6_fill.png

code source:

public class ChristmasTree {

private MarvinImagePlugin fill = MarvinPluginLoader.loadImagePlugin("org.marvinproject.image.fill.boundaryFill");

private MarvinImagePlugin threshold = MarvinPluginLoader.loadImagePlugin("org.marvinproject.image.color.thresholding");

private MarvinImagePlugin invert = MarvinPluginLoader.loadImagePlugin("org.marvinproject.image.color.invert");

private MarvinImagePlugin dilation = MarvinPluginLoader.loadImagePlugin("org.marvinproject.image.morphological.dilation");

public ChristmasTree(){

MarvinImage tree;

// Iterate each image

for(int i=1; i<=6; i++){

tree = MarvinImageIO.loadImage("./res/trees/tree"+i+".png");

// 1. Threshold

threshold.setAttribute("threshold", 200);

threshold.process(tree.clone(), tree);

// 2. Dilate

invert.process(tree.clone(), tree);

tree = MarvinColorModelConverter.rgbToBinary(tree, 127);

MarvinImageIO.saveImage(tree, "./res/trees/new/tree_"+i+"threshold.png");

dilation.setAttribute("matrix", MarvinMath.getTrueMatrix(50, 50));

dilation.process(tree.clone(), tree);

MarvinImageIO.saveImage(tree, "./res/trees/new/tree_"+1+"_dilation.png");

tree = MarvinColorModelConverter.binaryToRgb(tree);

// 3. Segment shapes

MarvinImage trees2 = tree.clone();

fill(tree, trees2);

MarvinImageIO.saveImage(trees2, "./res/trees/new/tree_"+i+"_fill.png");

}

private void fill(MarvinImage imageIn, MarvinImage imageOut){

boolean found;

int color= 0xFFFF0000;

while(true){

found=false;

Outerloop:

for(int y=0; y<imageIn.getHeight(); y++){

for(int x=0; x<imageIn.getWidth(); x++){

if(imageOut.getIntComponent0(x, y) == 0){

fill.setAttribute("x", x);

fill.setAttribute("y", y);

fill.setAttribute("color", color);

fill.setAttribute("threshold", 120);

fill.process(imageIn, imageOut);

color = newColor(color);

found = true;

break Outerloop;

}

}

}

if(!found){

break;

}

}

}

private int newColor(int color){

int red = (color & 0x00FF0000) >> 16;

int green = (color & 0x0000FF00) >> 8;

int blue = (color & 0x000000FF);

if(red <= green && red <= blue){

red+=5;

}

else if(green <= red && green <= blue){

green+=5;

}

else{

blue+=5;

}

return 0xFF000000 + (red << 16) + (green << 8) + blue;

}

public static void main(String[] args) {

new ChristmasTree();

}

}

comme indiqué dans l'image de sortie, plusieurs formes ont été détectées. Dans ce problème, il y a juste quelques points lumineux dans les images. Toutefois, cette approche a été mise en œuvre pour faire face à des scénarios plus complexes.

dans la prochaine étape chaque forme est analysée. Un algorithme simple détecte des formes avec un modèle semblable à un triangle. L'algorithme d'analyser la forme de l'objet, ligne par ligne. Si le centre de la masse de chaque ligne de forme est presque le même (avec un seuil) et que la masse augmente avec l'augmentation de y, l'objet a une forme triangulaire. La masse de la ligne de forme est le nombre de pixels dans cette ligne qui appartient à la forme. Imaginez que vous coupez l'objet horizontalement et analysez chaque segment horizontal. Si elles sont centralisées l'une à l'autre et la longueur augmente du premier segment à le dernier dans un motif linéaire, vous avez probablement un objet qui ressemble à un triangle.

code source:

private int[] detectTrees(MarvinImage image){

HashSet<Integer> analysed = new HashSet<Integer>();

boolean found;

while(true){

found = false;

for(int y=0; y<image.getHeight(); y++){

for(int x=0; x<image.getWidth(); x++){

int color = image.getIntColor(x, y);

if(!analysed.contains(color)){

if(isTree(image, color)){

return getObjectRect(image, color);

}

analysed.add(color);

found=true;

}

}

}

if(!found){

break;

}

}

return null;

}

private boolean isTree(MarvinImage image, int color){

int mass[][] = new int[image.getHeight()][2];

int yStart=-1;

int xStart=-1;

for(int y=0; y<image.getHeight(); y++){

int mc = 0;

int xs=-1;

int xe=-1;

for(int x=0; x<image.getWidth(); x++){

if(image.getIntColor(x, y) == color){

mc++;

if(yStart == -1){

yStart=y;

xStart=x;

}

if(xs == -1){

xs = x;

}

if(x > xe){

xe = x;

}

}

}

mass[y][0] = xs;

mass[y][3] = xe;

mass[y][4] = mc;

}

int validLines=0;

for(int y=0; y<image.getHeight(); y++){

if

(

mass[y][5] > 0 &&

Math.abs(((mass[y][0]+mass[y][6])/2)-xStart) <= 50 &&

mass[y][7] >= (mass[yStart][8] + (y-yStart)*0.3) &&

mass[y][9] <= (mass[yStart][10] + (y-yStart)*1.5)

)

{

validLines++;

}

}

if(validLines > 100){

return true;

}

return false;

}

enfin, la position de chaque forme semblable à un triangle et avec une luminosité significative, dans ce cas un arbre de Noël, est mise en évidence dans l'image originale, comme montré ci-dessous.

images de sortie finale:

http://marvinproject.sourceforge.net/other/trees/tree_1_out_2.jpg http://marvinproject.sourceforge.net/other/trees/tree_2_out_2.jpg http://marvinproject.sourceforge.net/other/trees/tree_3_out_2.jpg

http://marvinproject.sourceforge.net/other/trees/tree_4_out_2.jpg http://marvinproject.sourceforge.net/other/trees/tree_5_out_2.jpg http://marvinproject.sourceforge.net/other/trees/tree_6_out_2.jpg

code source final:

public class ChristmasTree {

private MarvinImagePlugin fill = MarvinPluginLoader.loadImagePlugin("org.marvinproject.image.fill.boundaryFill");

private MarvinImagePlugin threshold = MarvinPluginLoader.loadImagePlugin("org.marvinproject.image.color.thresholding");

private MarvinImagePlugin invert = MarvinPluginLoader.loadImagePlugin("org.marvinproject.image.color.invert");

private MarvinImagePlugin dilation = MarvinPluginLoader.loadImagePlugin("org.marvinproject.image.morphological.dilation");

public ChristmasTree(){

MarvinImage tree;

// Iterate each image

for(int i=1; i<=6; i++){

tree = MarvinImageIO.loadImage("./res/trees/tree"+i+".png");

// 1. Threshold

threshold.setAttribute("threshold", 200);

threshold.process(tree.clone(), tree);

// 2. Dilate

invert.process(tree.clone(), tree);

tree = MarvinColorModelConverter.rgbToBinary(tree, 127);

MarvinImageIO.saveImage(tree, "./res/trees/new/tree_"+i+"threshold.png");

dilation.setAttribute("matrix", MarvinMath.getTrueMatrix(50, 50));

dilation.process(tree.clone(), tree);

MarvinImageIO.saveImage(tree, "./res/trees/new/tree_"+1+"_dilation.png");

tree = MarvinColorModelConverter.binaryToRgb(tree);

// 3. Segment shapes

MarvinImage trees2 = tree.clone();

fill(tree, trees2);

MarvinImageIO.saveImage(trees2, "./res/trees/new/tree_"+i+"_fill.png");

// 4. Detect tree-like shapes

int[] rect = detectTrees(trees2);

// 5. Draw the result

MarvinImage original = MarvinImageIO.loadImage("./res/trees/tree"+i+".png");

drawBoundary(trees2, original, rect);

MarvinImageIO.saveImage(original, "./res/trees/new/tree_"+i+"_out_2.jpg");

}

}

private void drawBoundary(MarvinImage shape, MarvinImage original, int[] rect){

int yLines[] = new int[6];

yLines[0] = rect[1];

yLines[1] = rect[1]+(int)((rect[3]/5));

yLines[2] = rect[1]+((rect[3]/5)*2);

yLines[3] = rect[1]+((rect[3]/5)*3);

yLines[4] = rect[1]+(int)((rect[3]/5)*4);

yLines[5] = rect[1]+rect[3];

List<Point> points = new ArrayList<Point>();

for(int i=0; i<yLines.length; i++){

boolean in=false;

Point startPoint=null;

Point endPoint=null;

for(int x=rect[0]; x<rect[0]+rect[2]; x++){

if(shape.getIntColor(x, yLines[i]) != 0xFFFFFFFF){

if(!in){

if(startPoint == null){

startPoint = new Point(x, yLines[i]);

}

}

in = true;

}

else{

if(in){

endPoint = new Point(x, yLines[i]);

}

in = false;

}

}

if(endPoint == null){

endPoint = new Point((rect[0]+rect[2])-1, yLines[i]);

}

points.add(startPoint);

points.add(endPoint);

}

drawLine(points.get(0).x, points.get(0).y, points.get(1).x, points.get(1).y, 15, original);

drawLine(points.get(1).x, points.get(1).y, points.get(3).x, points.get(3).y, 15, original);

drawLine(points.get(3).x, points.get(3).y, points.get(5).x, points.get(5).y, 15, original);

drawLine(points.get(5).x, points.get(5).y, points.get(7).x, points.get(7).y, 15, original);

drawLine(points.get(7).x, points.get(7).y, points.get(9).x, points.get(9).y, 15, original);

drawLine(points.get(9).x, points.get(9).y, points.get(11).x, points.get(11).y, 15, original);

drawLine(points.get(11).x, points.get(11).y, points.get(10).x, points.get(10).y, 15, original);

drawLine(points.get(10).x, points.get(10).y, points.get(8).x, points.get(8).y, 15, original);

drawLine(points.get(8).x, points.get(8).y, points.get(6).x, points.get(6).y, 15, original);

drawLine(points.get(6).x, points.get(6).y, points.get(4).x, points.get(4).y, 15, original);

drawLine(points.get(4).x, points.get(4).y, points.get(2).x, points.get(2).y, 15, original);

drawLine(points.get(2).x, points.get(2).y, points.get(0).x, points.get(0).y, 15, original);

}

private void drawLine(int x1, int y1, int x2, int y2, int length, MarvinImage image){

int lx1, lx2, ly1, ly2;

for(int i=0; i<length; i++){

lx1 = (x1+i >= image.getWidth() ? (image.getWidth()-1)-i: x1);

lx2 = (x2+i >= image.getWidth() ? (image.getWidth()-1)-i: x2);

ly1 = (y1+i >= image.getHeight() ? (image.getHeight()-1)-i: y1);

ly2 = (y2+i >= image.getHeight() ? (image.getHeight()-1)-i: y2);

image.drawLine(lx1+i, ly1, lx2+i, ly2, Color.red);

image.drawLine(lx1, ly1+i, lx2, ly2+i, Color.red);

}

}

private void fillRect(MarvinImage image, int[] rect, int length){

for(int i=0; i<length; i++){

image.drawRect(rect[0]+i, rect[1]+i, rect[2]-(i*2), rect[3]-(i*2), Color.red);

}

}

private void fill(MarvinImage imageIn, MarvinImage imageOut){

boolean found;

int color= 0xFFFF0000;

while(true){

found=false;

Outerloop:

for(int y=0; y<imageIn.getHeight(); y++){

for(int x=0; x<imageIn.getWidth(); x++){

if(imageOut.getIntComponent0(x, y) == 0){

fill.setAttribute("x", x);

fill.setAttribute("y", y);

fill.setAttribute("color", color);

fill.setAttribute("threshold", 120);

fill.process(imageIn, imageOut);

color = newColor(color);

found = true;

break Outerloop;

}

}

}

if(!found){

break;

}

}

}

private int[] detectTrees(MarvinImage image){

HashSet<Integer> analysed = new HashSet<Integer>();

boolean found;

while(true){

found = false;

for(int y=0; y<image.getHeight(); y++){

for(int x=0; x<image.getWidth(); x++){

int color = image.getIntColor(x, y);

if(!analysed.contains(color)){

if(isTree(image, color)){

return getObjectRect(image, color);

}

analysed.add(color);

found=true;

}

}

}

if(!found){

break;

}

}

return null;

}

private boolean isTree(MarvinImage image, int color){

int mass[][] = new int[image.getHeight()][11];

int yStart=-1;

int xStart=-1;

for(int y=0; y<image.getHeight(); y++){

int mc = 0;

int xs=-1;

int xe=-1;

for(int x=0; x<image.getWidth(); x++){

if(image.getIntColor(x, y) == color){

mc++;

if(yStart == -1){

yStart=y;

xStart=x;

}

if(xs == -1){

xs = x;

}

if(x > xe){

xe = x;

}

}

}

mass[y][0] = xs;

mass[y][12] = xe;

mass[y][13] = mc;

}

int validLines=0;

for(int y=0; y<image.getHeight(); y++){

if

(

mass[y][14] > 0 &&

Math.abs(((mass[y][0]+mass[y][15])/2)-xStart) <= 50 &&

mass[y][16] >= (mass[yStart][17] + (y-yStart)*0.3) &&

mass[y][18] <= (mass[yStart][19] + (y-yStart)*1.5)

)

{

validLines++;

}

}

if(validLines > 100){

return true;

}

return false;

}

private int[] getObjectRect(MarvinImage image, int color){

int x1=-1;

int x2=-1;

int y1=-1;

int y2=-1;

for(int y=0; y<image.getHeight(); y++){

for(int x=0; x<image.getWidth(); x++){

if(image.getIntColor(x, y) == color){

if(x1 == -1 || x < x1){

x1 = x;

}

if(x2 == -1 || x > x2){

x2 = x;

}

if(y1 == -1 || y < y1){

y1 = y;

}

if(y2 == -1 || y > y2){

y2 = y;

}

}

}

}

return new int[]{x1, y1, (x2-x1), (y2-y1)};

}

private int newColor(int color){

int red = (color & 0x00FF0000) >> 16;

int green = (color & 0x0000FF00) >> 8;

int blue = (color & 0x000000FF);

if(red <= green && red <= blue){

red+=5;

}

else if(green <= red && green <= blue){

green+=30;

}

else{

blue+=30;

}

return 0xFF000000 + (red << 16) + (green << 8) + blue;

}

public static void main(String[] args) {

new ChristmasTree();

}

}

l'avantage de cette approche est le fait qu'elle fonctionnera probablement avec des images contenant d'autres objets lumineux puisqu'elle analyse la forme de l'objet.

Joyeux Noël!

MODIFIER LA NOTE 2

il y a une discussion sur la similitude des images de sortie de cette solution et d'autres. En fait, ils sont très similaires. Mais cette approche ne segmente pas seulement les objets. Il analyse également les formes de l'objet dans un certain sens. Il peut traiter plusieurs objets lumineux dans la même scène. En fait, l'arbre de Noël n'a pas besoin d'être la plus brillante. Je l'aborde pour enrichir la discussion. Il y a un biais dans les échantillons qui juste à la recherche de l'objet le plus brillant, vous trouverez les arbres. Mais, voulons-nous vraiment arrêter la discussion à ce stade? À ce stade, dans quelle mesure l'ordinateur reconnaît-il vraiment un objet qui ressemble à un arbre de Noël? Nous allons tenter de combler cet écart.

ci-dessous est présenté un résultat juste pour élucider ce point:

image d'entrée

sortie

voici ma solution simple et stupide. Il est basé sur l'hypothèse que l'arbre sera la plus brillante et la grande chose dans l'image.

//g++ -Wall -pedantic -ansi -O2 -pipe -s -o christmas_tree christmas_tree.cpp `pkg-config --cflags --libs opencv`

#include <opencv2/imgproc/imgproc.hpp>

#include <opencv2/highgui/highgui.hpp>

#include <iostream>

using namespace cv;

using namespace std;

int main(int argc,char *argv[])

{

Mat original,tmp,tmp1;

vector <vector<Point> > contours;

Moments m;

Rect boundrect;

Point2f center;

double radius, max_area=0,tmp_area=0;

unsigned int j, k;

int i;

for(i = 1; i < argc; ++i)

{

original = imread(argv[i]);

if(original.empty())

{

cerr << "Error"<<endl;

return -1;

}

GaussianBlur(original, tmp, Size(3, 3), 0, 0, BORDER_DEFAULT);

erode(tmp, tmp, Mat(), Point(-1, -1), 10);

cvtColor(tmp, tmp, CV_BGR2HSV);

inRange(tmp, Scalar(0, 0, 0), Scalar(180, 255, 200), tmp);

dilate(original, tmp1, Mat(), Point(-1, -1), 15);

cvtColor(tmp1, tmp1, CV_BGR2HLS);

inRange(tmp1, Scalar(0, 185, 0), Scalar(180, 255, 255), tmp1);

dilate(tmp1, tmp1, Mat(), Point(-1, -1), 10);

bitwise_and(tmp, tmp1, tmp1);

findContours(tmp1, contours, CV_RETR_EXTERNAL, CV_CHAIN_APPROX_SIMPLE);

max_area = 0;

j = 0;

for(k = 0; k < contours.size(); k++)

{

tmp_area = contourArea(contours[k]);

if(tmp_area > max_area)

{

max_area = tmp_area;

j = k;

}

}

tmp1 = Mat::zeros(original.size(),CV_8U);

approxPolyDP(contours[j], contours[j], 30, true);

drawContours(tmp1, contours, j, Scalar(255,255,255), CV_FILLED);

m = moments(contours[j]);

boundrect = boundingRect(contours[j]);

center = Point2f(m.m10/m.m00, m.m01/m.m00);

radius = (center.y - (boundrect.tl().y))/4.0*3.0;

Rect heightrect(center.x-original.cols/5, boundrect.tl().y, original.cols/5*2, boundrect.size().height);

tmp = Mat::zeros(original.size(), CV_8U);

rectangle(tmp, heightrect, Scalar(255, 255, 255), -1);

circle(tmp, center, radius, Scalar(255, 255, 255), -1);

bitwise_and(tmp, tmp1, tmp1);

findContours(tmp1, contours, CV_RETR_EXTERNAL, CV_CHAIN_APPROX_SIMPLE);

max_area = 0;

j = 0;

for(k = 0; k < contours.size(); k++)

{

tmp_area = contourArea(contours[k]);

if(tmp_area > max_area)

{

max_area = tmp_area;

j = k;

}

}

approxPolyDP(contours[j], contours[j], 30, true);

convexHull(contours[j], contours[j]);

drawContours(original, contours, j, Scalar(0, 0, 255), 3);

namedWindow(argv[i], CV_WINDOW_NORMAL|CV_WINDOW_KEEPRATIO|CV_GUI_EXPANDED);

imshow(argv[i], original);

waitKey(0);

destroyWindow(argv[i]);

}

return 0;

}

La première étape est de détecter le plus lumineux de pixels dans l'image, mais nous devons faire une distinction entre l'arbre lui-même et la neige qui reflètent la lumière. Ici, nous essayons d'exclure la neige appliquer un filtre très simple sur les codes de couleur:

GaussianBlur(original, tmp, Size(3, 3), 0, 0, BORDER_DEFAULT);

erode(tmp, tmp, Mat(), Point(-1, -1), 10);

cvtColor(tmp, tmp, CV_BGR2HSV);

inRange(tmp, Scalar(0, 0, 0), Scalar(180, 255, 200), tmp);

alors nous trouvons chaque "bright" pixel:

dilate(original, tmp1, Mat(), Point(-1, -1), 15);

cvtColor(tmp1, tmp1, CV_BGR2HLS);

inRange(tmp1, Scalar(0, 185, 0), Scalar(180, 255, 255), tmp1);

dilate(tmp1, tmp1, Mat(), Point(-1, -1), 10);

enfin nous joignons les deux résultats:

bitwise_and(tmp, tmp1, tmp1);

maintenant nous cherchons le plus grand objet lumineux:

findContours(tmp1, contours, CV_RETR_EXTERNAL, CV_CHAIN_APPROX_SIMPLE);

max_area = 0;

j = 0;

for(k = 0; k < contours.size(); k++)

{

tmp_area = contourArea(contours[k]);

if(tmp_area > max_area)

{

max_area = tmp_area;

j = k;

}

}

tmp1 = Mat::zeros(original.size(),CV_8U);

approxPolyDP(contours[j], contours[j], 30, true);

drawContours(tmp1, contours, j, Scalar(255,255,255), CV_FILLED);

maintenant nous avons presque fini, mais il y a encore quelques imperfections dues à la neige. Pour les découper, nous construirons un masque à l'aide d'un cercle et d'un rectangle pour se rapprocher de la forme d'un arbre afin de supprimer les pièces indésirables:

m = moments(contours[j]);

boundrect = boundingRect(contours[j]);

center = Point2f(m.m10/m.m00, m.m01/m.m00);

radius = (center.y - (boundrect.tl().y))/4.0*3.0;

Rect heightrect(center.x-original.cols/5, boundrect.tl().y, original.cols/5*2, boundrect.size().height);

tmp = Mat::zeros(original.size(), CV_8U);

rectangle(tmp, heightrect, Scalar(255, 255, 255), -1);

circle(tmp, center, radius, Scalar(255, 255, 255), -1);

bitwise_and(tmp, tmp1, tmp1);

La dernière étape est de trouver le le contour de notre arbre et de le dessiner sur l'image d'origine.

findContours(tmp1, contours, CV_RETR_EXTERNAL, CV_CHAIN_APPROX_SIMPLE);

max_area = 0;

j = 0;

for(k = 0; k < contours.size(); k++)

{

tmp_area = contourArea(contours[k]);

if(tmp_area > max_area)

{

max_area = tmp_area;

j = k;

}

}

approxPolyDP(contours[j], contours[j], 30, true);

convexHull(contours[j], contours[j]);

drawContours(original, contours, j, Scalar(0, 0, 255), 3);

je suis désolé mais pour le moment j'ai une mauvaise connexion donc il n'est pas possible pour moi de télécharger des photos. Je vais essayer de le faire plus tard.

Joyeux Noël.

EDIT:

voici quelques photos de la sortie finale:

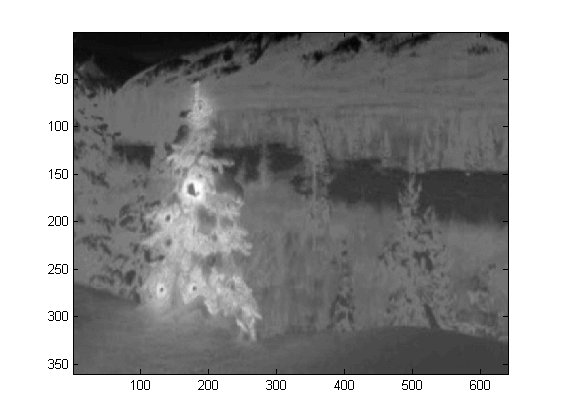

j'ai écrit le code dans Matlab R2007a. J'ai utilisé k-means pour extraire l'arbre de Noël. Je affiche mon résultat intermédiaire seulement avec une image, et les résultats finaux avec les six.

tout d'abord, j'ai cartographié L'espace RVB sur L'Espace Lab, ce qui pourrait augmenter le contraste du rouge dans son canal b:

colorTransform = makecform('srgb2lab');

I = applycform(I, colorTransform);

L = double(I(:,:,1));

a = double(I(:,:,2));

b = double(I(:,:,3));

outre le trait dans l'espace de couleur, j'ai également employé trait de texture qui est en rapport avec le quartier plutôt que chaque pixel lui-même. Ici, j'ai combiné de façon linéaire l'intensité de la 3 canaux originaux (R,G,B). La raison pour laquelle j'ai formaté de cette façon est parce que le Noël les arbres dans l'image ont tous feux rouges sur eux, et parfois vert/bleu l'éclairage ainsi.

R=double(Irgb(:,:,1));

G=double(Irgb(:,:,2));

B=double(Irgb(:,:,3));

I0 = (3*R + max(G,B)-min(G,B))/2;

j'ai appliqué un motif binaire local 3X3 sur I0 , j'ai utilisé le pixel central comme seuil, et

obtenu le contraste en calculant la différence entre la valeur moyenne de l'intensité du pixel

au-dessus du seuil et la valeur moyenne au-dessous.

I0_copy = zeros(size(I0));

for i = 2 : size(I0,1) - 1

for j = 2 : size(I0,2) - 1

tmp = I0(i-1:i+1,j-1:j+1) >= I0(i,j);

I0_copy(i,j) = mean(mean(tmp.*I0(i-1:i+1,j-1:j+1))) - ...

mean(mean(~tmp.*I0(i-1:i+1,j-1:j+1))); % Contrast

end

end

comme j'ai 4 Caractéristiques au total, je choisirais K=5 dans ma méthode de regroupement. Le code de les moyennes de k sont indiquées ci-dessous (elles proviennent du cours d'apprentissage automatique du Dr Andrew Ng. J'ai pris le cours avant, et j'ai écrit le code moi-même, dans sa programmation affectation.)

[centroids, idx] = runkMeans(X, initial_centroids, max_iters);

mask=reshape(idx,img_size(1),img_size(2));

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

function [centroids, idx] = runkMeans(X, initial_centroids, ...

max_iters, plot_progress)

[m n] = size(X);

K = size(initial_centroids, 1);

centroids = initial_centroids;

previous_centroids = centroids;

idx = zeros(m, 1);

for i=1:max_iters

% For each example in X, assign it to the closest centroid

idx = findClosestCentroids(X, centroids);

% Given the memberships, compute new centroids

centroids = computeCentroids(X, idx, K);

end

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

function idx = findClosestCentroids(X, centroids)

K = size(centroids, 1);

idx = zeros(size(X,1), 1);

for xi = 1:size(X,1)

x = X(xi, :);

% Find closest centroid for x.

best = Inf;

for mui = 1:K

mu = centroids(mui, :);

d = dot(x - mu, x - mu);

if d < best

best = d;

idx(xi) = mui;

end

end

end

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

function centroids = computeCentroids(X, idx, K)

[m n] = size(X);

centroids = zeros(K, n);

for mui = 1:K

centroids(mui, :) = sum(X(idx == mui, :)) / sum(idx == mui);

end

comme le programme tourne très lentement dans mon ordinateur, je viens de lancer 3 itérations. Normalement l'arrêt les critères (i) d'itération de temps, au moins 10, ou (ii) pas de changement sur les centroïdes. De mon test, en augmentant l'itération peut différencier fond (ciel et arbre, ciel et bâtiment.,..) plus précisément, mais n'a pas montré de changements drastiques dans l'arbre de Noël extraction. Notez également que k-means n'est pas à l'abri de l'initialisation centroïde aléatoire, il est donc recommandé d'exécuter le programme plusieurs fois pour faire une comparaison.

après le k-means, la région marquée avec l'intensité maximale de I0 a été choisie. Et

le tracé des frontières a été utilisé pour en extraire les limites. Pour moi, le dernier arbre de noël est le plus difficile à extraire depuis le contraste de cette image n'est pas assez élevée, car ils sont dans les cinq premiers. Un autre problème dans ma méthode est que j'ai utilisé la fonction bwboundaries dans Matlab pour tracer la limite, mais parfois les limites intérieures sont également inclus comme vous pouvez l'observer dans les résultats 3, 5, 6. Le côté sombre dans les arbres de Noël ne sont pas seulement échoué à être regroupés avec le côté éclairé, mais ils conduisent aussi à tant de minuscules limites intérieures traçant ( imfill n'améliore pas beaucoup). Dans tout mon algorithme a encore beaucoup d'espace d'amélioration.

Some publication s indique que le déplacement moyen peut être plus robuste que k-means, et de nombreux algorithmes basés sur des coupes graphiques sont également très concurrence sur des limites compliquées segmentation. J'ai écrit un algorithme mean-shift moi-même, il semble mieux extraire les régions sans assez de lumière. Mais le décalage moyen est un peu trop segmenté, et une certaine stratégie de la fusion est nécessaire. Il a fonctionné encore plus lentement que k-means dans mon ordinateur, je crains que je n'ai à l'abandonner. J'ai attendons avec impatience de voir d'autres pourraient présenter d'excellents résultats ici avec ces algorithmes modernes mentionnés ci-dessus.

pourtant je crois toujours la sélection des caractéristiques est la composante clé de la segmentation de l'image. Avec une sélection appropriée des caractéristiques qui peut maximiser la marge entre l'objet et l'arrière-plan, les algorithmes de segmentation fonctionneront. Différents algorithmes peuvent améliorer le résultat de 1 à 10, mais la fonctionnalité de sélection peut l'améliorer de 0 à 1.

Joyeux Noël !

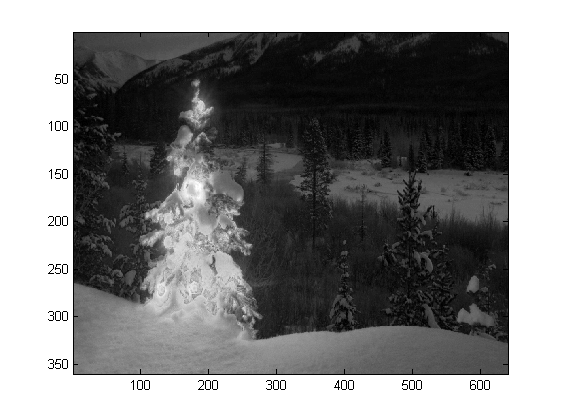

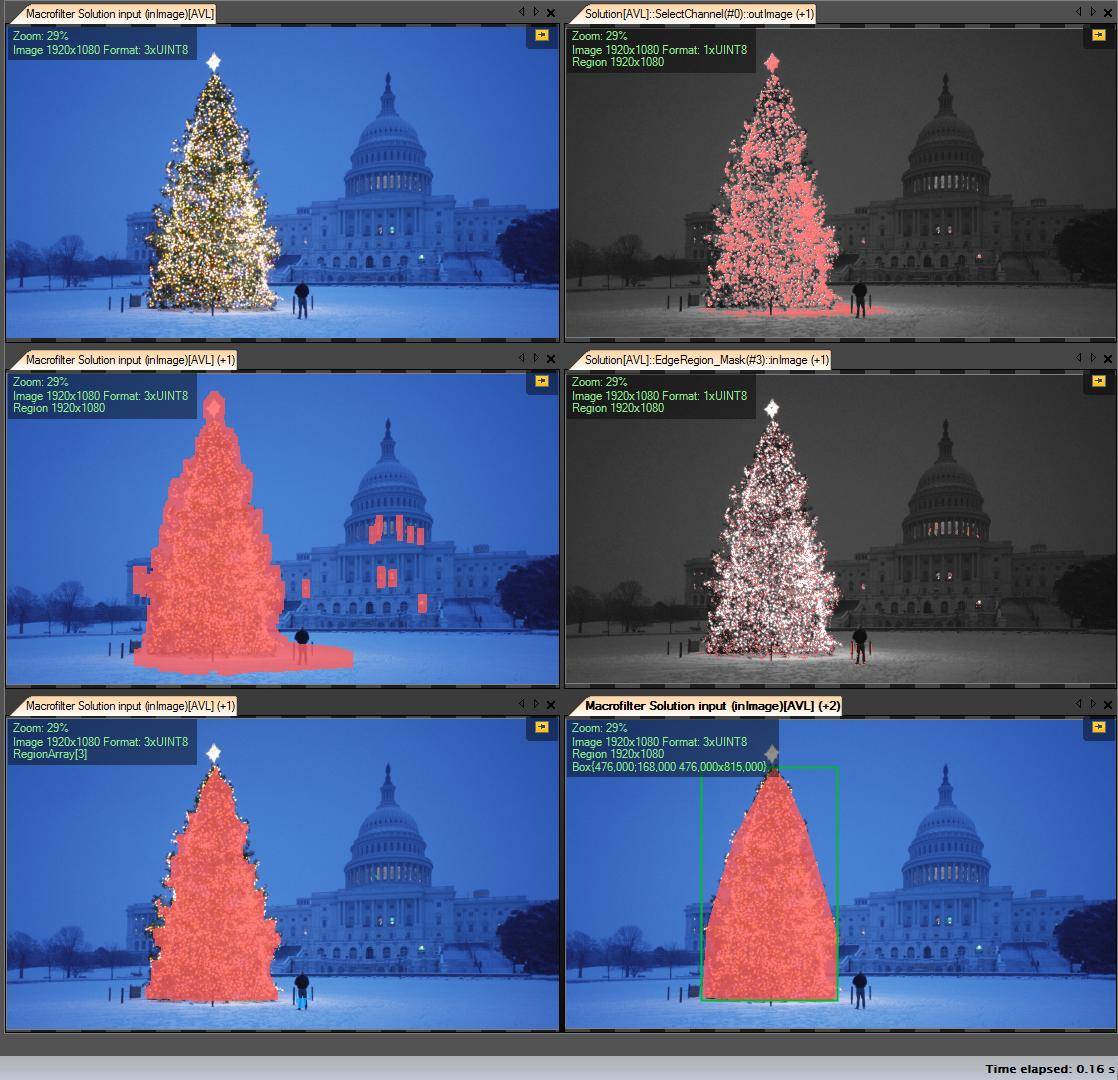

Ceci est mon dernier post à l'aide de l'image traditionnelle de traitement des approches...

ici, je combine en quelque sorte mes deux autres propositions, achieving even better results . En fait, je ne vois pas comment ces résultats pourraient être meilleurs (surtout quand vous regardez les images masquées que la méthode produit).

Au cœur de l'approche est la combinaison de trois hypothèses clés :

- les Images devraient avoir de fortes fluctuations dans les régions arborescentes

- les Images doivent avoir une intensité plus élevée dans l'arbre des régions

- Fond régions de faible intensité et surtout bleu-ish

avec ces hypothèses à l'esprit, la méthode fonctionne comme suit:

- Convertissez les images en HSV

- filtrer le canal V avec un filtre de LoG

- Appliquer un seuillage dur sur Journal d'image filtrée pour obtenir une 'activité' masque d'Une

- Appliquer un seuillage dur à V canal pour obtenir l'intensité masque B

- Appliquer H canal de seuillage pour la capture de faible intensité bleu-ish régions en arrière-plan masque C

- combiner les masques en utilisant et pour obtenir le masque final

- dilater le masque pour agrandir les régions et connecter les pixels dispersés

- éliminer les petites régions et obtenir le masque final qui représentera éventuellement seulement l'arbre

voici le code dans MATLAB (encore une fois, le script charge toutes les images jpg dans le dossier courant et, encore une fois, c'est loin d'être un morceau de code optimisé):

% clear everything

clear;

pack;

close all;

close all hidden;

drawnow;

clc;

% initialization

ims=dir('./*.jpg');

imgs={};

images={};

blur_images={};

log_image={};

dilated_image={};

int_image={};

back_image={};

bin_image={};

measurements={};

box={};

num=length(ims);

thres_div = 3;

for i=1:num,

% load original image

imgs{end+1}=imread(ims(i).name);

% convert to HSV colorspace

images{end+1}=rgb2hsv(imgs{i});

% apply laplacian filtering and heuristic hard thresholding

val_thres = (max(max(images{i}(:,:,3)))/thres_div);

log_image{end+1} = imfilter( images{i}(:,:,3),fspecial('log')) > val_thres;

% get the most bright regions of the image

int_thres = 0.26*max(max( images{i}(:,:,3)));

int_image{end+1} = images{i}(:,:,3) > int_thres;

% get the most probable background regions of the image

back_image{end+1} = images{i}(:,:,1)>(150/360) & images{i}(:,:,1)<(320/360) & images{i}(:,:,3)<0.5;

% compute the final binary image by combining

% high 'activity' with high intensity

bin_image{end+1} = logical( log_image{i}) & logical( int_image{i}) & ~logical( back_image{i});

% apply morphological dilation to connect distonnected components

strel_size = round(0.01*max(size(imgs{i}))); % structuring element for morphological dilation

dilated_image{end+1} = imdilate( bin_image{i}, strel('disk',strel_size));

% do some measurements to eliminate small objects

measurements{i} = regionprops( logical( dilated_image{i}),'Area','BoundingBox');

% iterative enlargement of the structuring element for better connectivity

while length(measurements{i})>14 && strel_size<(min(size(imgs{i}(:,:,1)))/2),

strel_size = round( 1.5 * strel_size);

dilated_image{i} = imdilate( bin_image{i}, strel('disk',strel_size));

measurements{i} = regionprops( logical( dilated_image{i}),'Area','BoundingBox');

end

for m=1:length(measurements{i})

if measurements{i}(m).Area < 0.05*numel( dilated_image{i})

dilated_image{i}( round(measurements{i}(m).BoundingBox(2):measurements{i}(m).BoundingBox(4)+measurements{i}(m).BoundingBox(2)),...

round(measurements{i}(m).BoundingBox(1):measurements{i}(m).BoundingBox(3)+measurements{i}(m).BoundingBox(1))) = 0;

end

end

% make sure the dilated image is the same size with the original

dilated_image{i} = dilated_image{i}(1:size(imgs{i},1),1:size(imgs{i},2));

% compute the bounding box

[y,x] = find( dilated_image{i});

if isempty( y)

box{end+1}=[];

else

box{end+1} = [ min(x) min(y) max(x)-min(x)+1 max(y)-min(y)+1];

end

end

%%% additional code to display things

for i=1:num,

figure;

subplot(121);

colormap gray;

imshow( imgs{i});

if ~isempty(box{i})

hold on;

rr = rectangle( 'position', box{i});

set( rr, 'EdgeColor', 'r');

hold off;

end

subplot(122);

imshow( imgs{i}.*uint8(repmat(dilated_image{i},[1 1 3])));

end

résultats

Haute résolution résultats encore disponible ici!

encore plus d'expériences avec des images supplémentaires peuvent être trouvées ici.

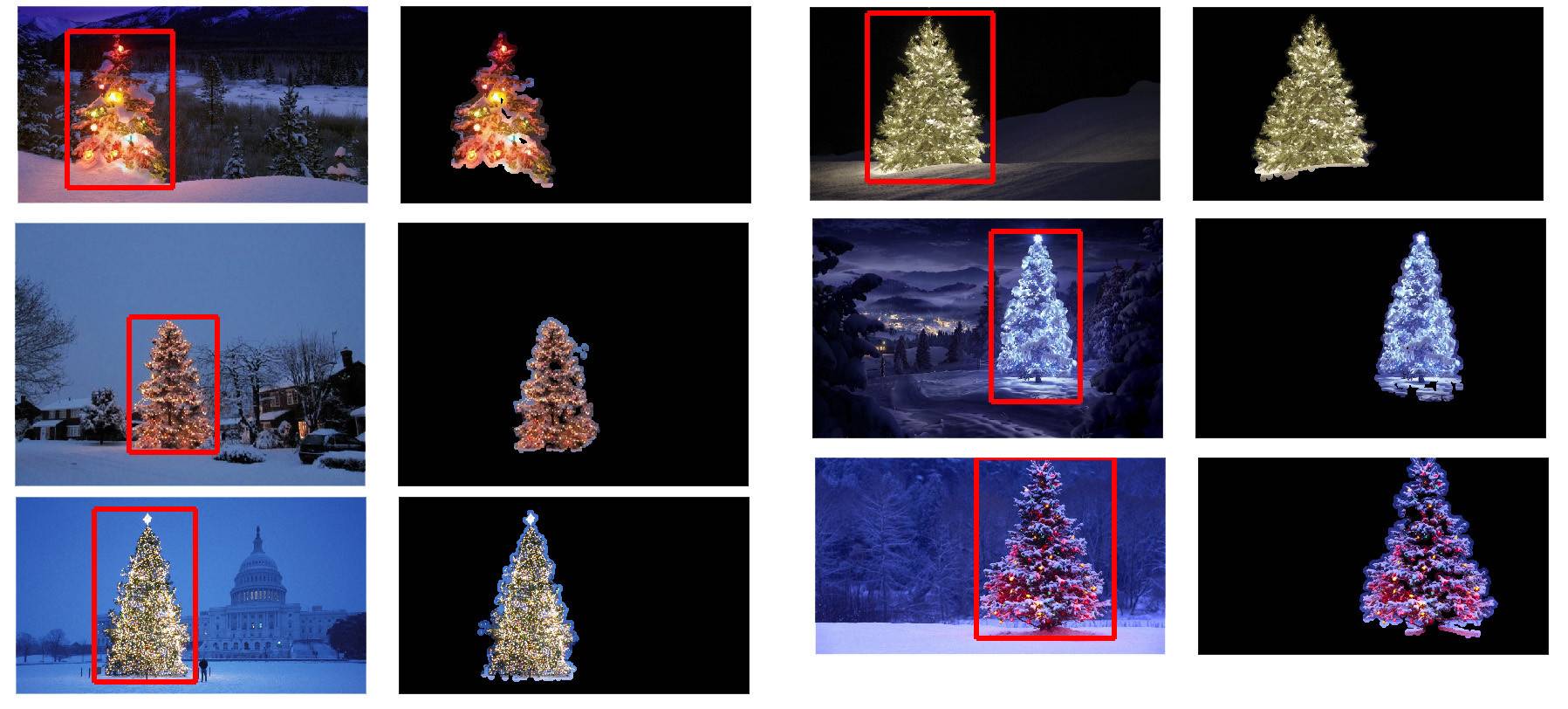

mes étapes de solution:

-

Get R channel (from RGB) - toutes les opérations que nous effectuons sur ce canal:

-

créer une région D'intérêt (ROI)

-

Seuil R canal avec valeur minimale 149 (image en haut à droite)

-

Dilater le résultat de la région (au milieu à gauche de l'image)

-

-

Détecter eges dans calculé le retour sur investissement. L'arbre a beaucoup de bords (au milieu à droite de l'image)

-

résultat dilaté

-

érosion avec un plus grand rayon (image en bas à gauche)

-

-

sélectionnez l'objet le plus grand (par zone) - c'est la région de résultat

-

ConvexHull (l'arbre est un polygone convexe) ) ( image en bas à droite)

-

boîte Englobante (en bas à droite de l'image - grren encadré )

étape par Étape:

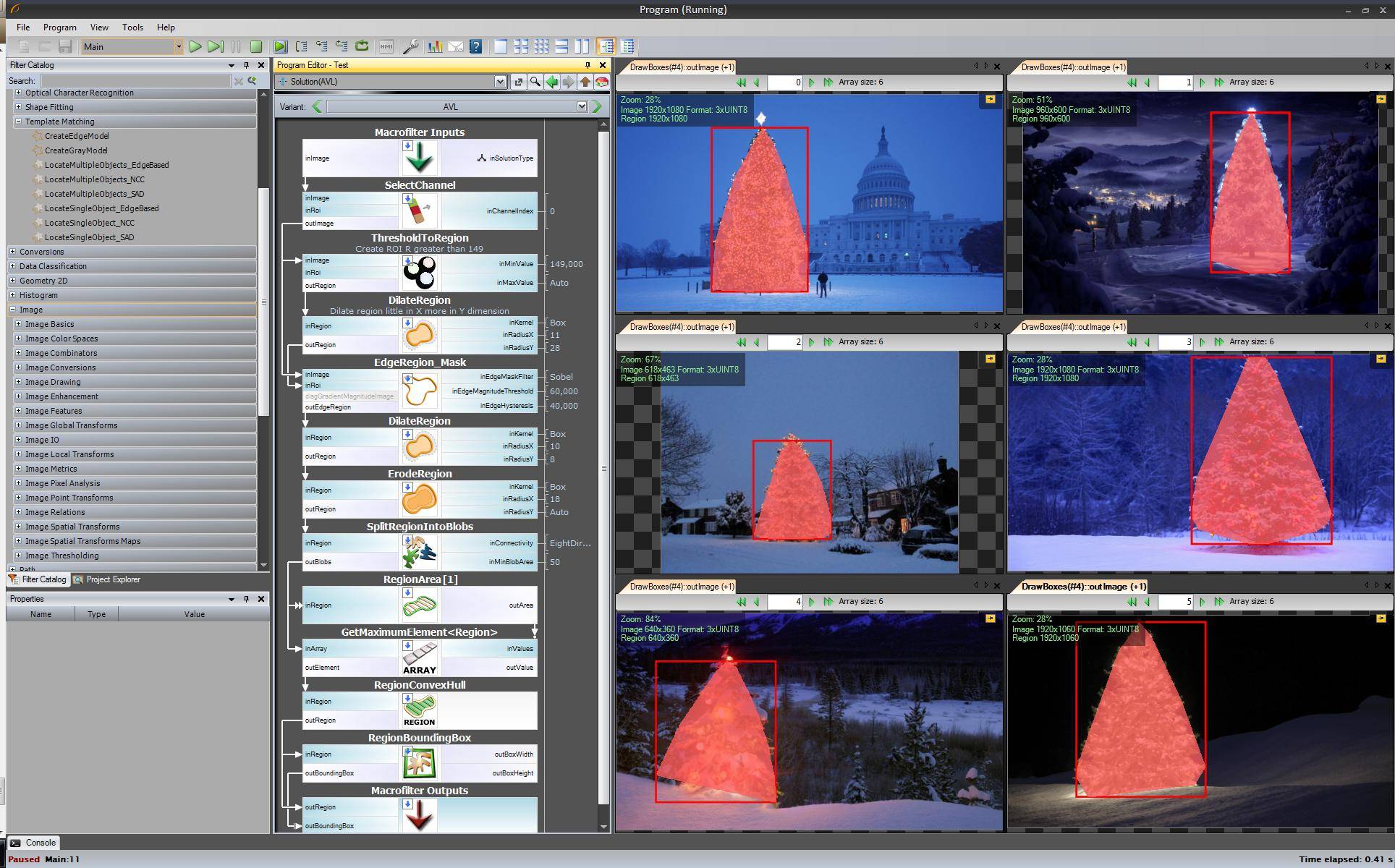

Le premier résultat - plus simple, mais pas dans les logiciels open source - "Adaptive Vision Studio + Adaptative Vision de la Bibliothèque": Ce n'est pas open source mais vraiment rapide à prototype:

algorithme complet pour détecter l'arbre de Noël (11 blocs):

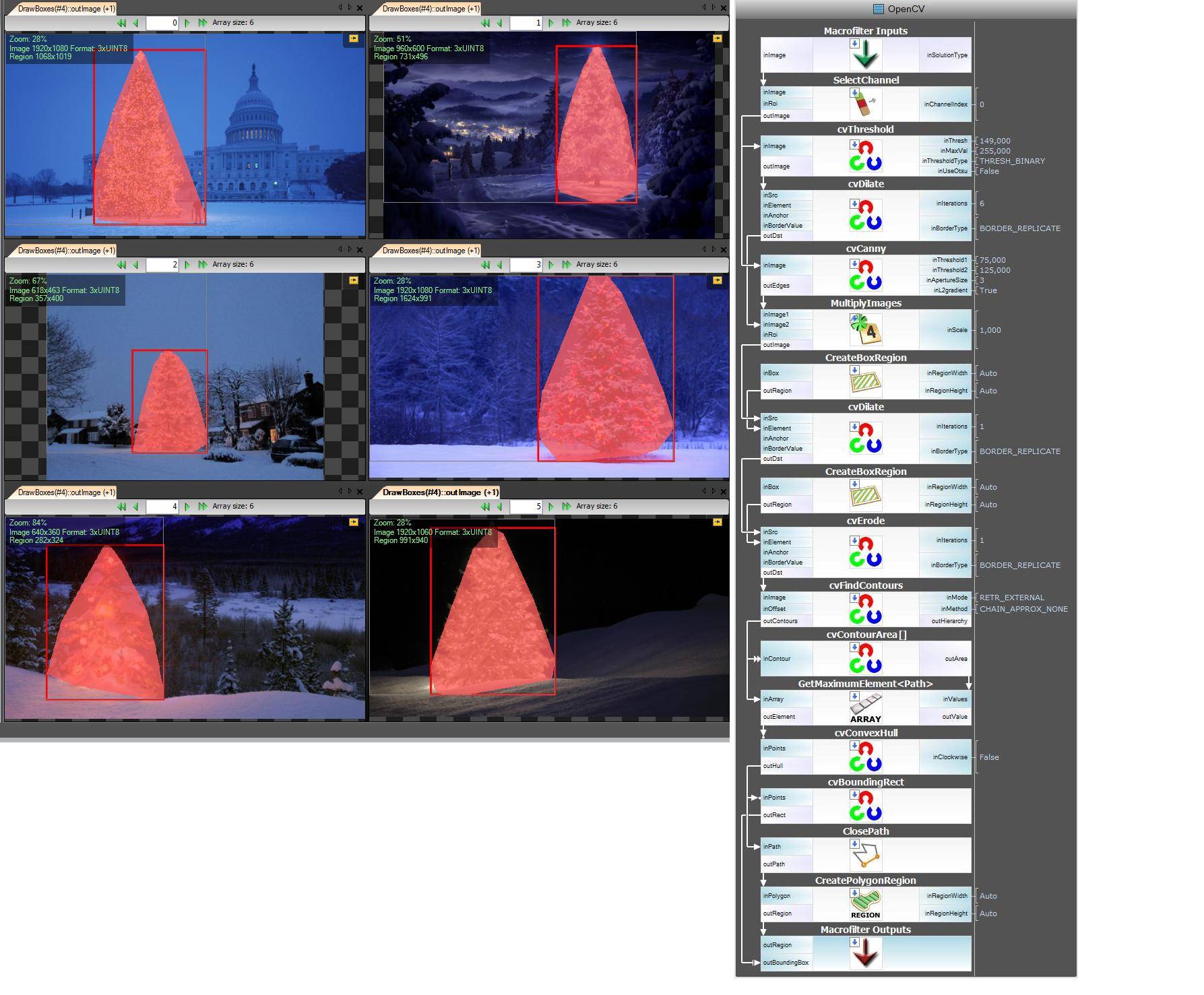

prochaine étape. Nous voulons une solution open source. Changer les filtres AVL en filtres OpenCV: Ici, j'ai fait peu de changements, par exemple la détection des bordures utiliser cvCanny filter, pour respecter le roi j'ai multiplié l'image de région avec l'image des bordures, pour sélectionner le plus grand élément j'ai utilisé findContours + contourArea mais l'idée est la même.

https://www.youtube.com/watch?v=sfjB3MigLH0&index=1&list=UUpSRrkMHNHiLDXgylwhWNQQ

Je ne peux pas montrer des images avec des étapes intermédiaires maintenant parce que je peux mettre seulement 2 liens.

Ok maintenant nous utilisons des filtres openSource mais ce n'est pas encore entièrement open source. Dernière étape-le port au code C++. J'ai utilisé OpenCV dans la version 2.4.4

le résultat final du code c++ est:

code c++ est aussi assez court:

#include "opencv2/highgui/highgui.hpp"

#include "opencv2/opencv.hpp"

#include <algorithm>

using namespace cv;

int main()

{

string images[6] = {"..\1.png","..\2.png","..\3.png","..\4.png","..\5.png","..\6.png"};

for(int i = 0; i < 6; ++i)

{

Mat img, thresholded, tdilated, tmp, tmp1;

vector<Mat> channels(3);

img = imread(images[i]);

split(img, channels);

threshold( channels[2], thresholded, 149, 255, THRESH_BINARY); //prepare ROI - threshold

dilate( thresholded, tdilated, getStructuringElement( MORPH_RECT, Size(22,22) ) ); //prepare ROI - dilate

Canny( channels[2], tmp, 75, 125, 3, true ); //Canny edge detection

multiply( tmp, tdilated, tmp1 ); // set ROI

dilate( tmp1, tmp, getStructuringElement( MORPH_RECT, Size(20,16) ) ); // dilate

erode( tmp, tmp1, getStructuringElement( MORPH_RECT, Size(36,36) ) ); // erode

vector<vector<Point> > contours, contours1(1);

vector<Point> convex;

vector<Vec4i> hierarchy;

findContours( tmp1, contours, hierarchy, CV_RETR_TREE, CV_CHAIN_APPROX_SIMPLE, Point(0, 0) );

//get element of maximum area

//int bestID = std::max_element( contours.begin(), contours.end(),

// []( const vector<Point>& A, const vector<Point>& B ) { return contourArea(A) < contourArea(B); } ) - contours.begin();

int bestID = 0;

int bestArea = contourArea( contours[0] );

for( int i = 1; i < contours.size(); ++i )

{

int area = contourArea( contours[i] );

if( area > bestArea )

{

bestArea = area;

bestID = i;

}

}

convexHull( contours[bestID], contours1[0] );

drawContours( img, contours1, 0, Scalar( 100, 100, 255 ), img.rows / 100, 8, hierarchy, 0, Point() );

imshow("image", img );

waitKey(0);

}

return 0;

}

...une autre solution à l'ancienne-purement basée sur le traitement HSV :

- Convertir des images en l'espace couleur HSV

- créer des masques selon les heuristiques dans le HSV (voir ci-dessous)

- appliquer une dilatation morphologique au masque pour connecter les zones déconnectées

- jeter les petits secteurs et les blocs horizontaux (rappelez-vous que les arbres sont des blocs verticaux)

- calculer la boîte de délimitation

Un mot sur l'heuristique dans le HSV de traitement:

- tout avec teintes (H) entre 210-320 degrés est écarté comme bleu-magenta qui est censé être à l'arrière-plan ou dans les zones non pertinentes

- tout avec valeurs (V) inférieur à 40% est également rejeté comme étant trop sombre pour être pertinent

bien sûr, on peut expérimenter de nombreuses autres possibilités pour affiner cette approche...

Voici le code MATLAB pour faire l'affaire (attention: le code est loin d'être optimisé!!! J'ai utilisé des techniques non recommandées pour la programmation de MATLAB juste pour pouvoir suivre n'importe quoi dans le processus-cela peut être grandement optimisé):

% clear everything

clear;

pack;

close all;

close all hidden;

drawnow;

clc;

% initialization

ims=dir('./*.jpg');

num=length(ims);

imgs={};

hsvs={};

masks={};

dilated_images={};

measurements={};

boxs={};

for i=1:num,

% load original image

imgs{end+1} = imread(ims(i).name);

flt_x_size = round(size(imgs{i},2)*0.005);

flt_y_size = round(size(imgs{i},1)*0.005);

flt = fspecial( 'average', max( flt_y_size, flt_x_size));

imgs{i} = imfilter( imgs{i}, flt, 'same');

% convert to HSV colorspace

hsvs{end+1} = rgb2hsv(imgs{i});

% apply a hard thresholding and binary operation to construct the mask

masks{end+1} = medfilt2( ~(hsvs{i}(:,:,1)>(210/360) & hsvs{i}(:,:,1)<(320/360))&hsvs{i}(:,:,3)>0.4);

% apply morphological dilation to connect distonnected components

strel_size = round(0.03*max(size(imgs{i}))); % structuring element for morphological dilation

dilated_images{end+1} = imdilate( masks{i}, strel('disk',strel_size));

% do some measurements to eliminate small objects

measurements{i} = regionprops( dilated_images{i},'Perimeter','Area','BoundingBox');

for m=1:length(measurements{i})

if (measurements{i}(m).Area < 0.02*numel( dilated_images{i})) || (measurements{i}(m).BoundingBox(3)>1.2*measurements{i}(m).BoundingBox(4))

dilated_images{i}( round(measurements{i}(m).BoundingBox(2):measurements{i}(m).BoundingBox(4)+measurements{i}(m).BoundingBox(2)),...

round(measurements{i}(m).BoundingBox(1):measurements{i}(m).BoundingBox(3)+measurements{i}(m).BoundingBox(1))) = 0;

end

end

dilated_images{i} = dilated_images{i}(1:size(imgs{i},1),1:size(imgs{i},2));

% compute the bounding box

[y,x] = find( dilated_images{i});

if isempty( y)

boxs{end+1}=[];

else

boxs{end+1} = [ min(x) min(y) max(x)-min(x)+1 max(y)-min(y)+1];

end

end

%%% additional code to display things

for i=1:num,

figure;

subplot(121);

colormap gray;

imshow( imgs{i});

if ~isempty(boxs{i})

hold on;

rr = rectangle( 'position', boxs{i});

set( rr, 'EdgeColor', 'r');

hold off;

end

subplot(122);

imshow( imgs{i}.*uint8(repmat(dilated_images{i},[1 1 3])));

end

Résultats:

dans le résultats je montre l'image masquée et la zone limite.

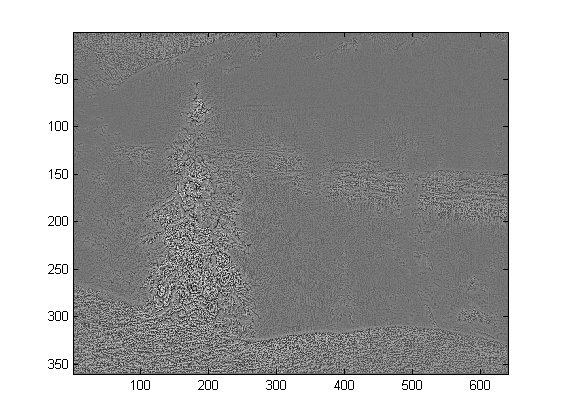

une approche de traitement d'image démodée...

L'idée est basée sur l'hypothèse selon laquelle les images représentent des arbres éclairés sur des fonds généralement plus foncés et plus lisses (ou des avant-terrains dans certains cas). La zone est plus "énergique" et a une intensité plus élevée .

Le processus est le suivant:

- convertir en graylevel

- appliquer un filtrage LoG pour obtenir les zones les plus" actives

- Appliquer une intentisy seuillage pour obtenir la plupart des zones lumineuses

- combiner les 2 précédents pour obtenir un masque préliminaire

- appliquer une dilatation morphologique pour agrandir les zones et relier les composants voisins

- éliminer les petites zones candidates en fonction de leur superficie

Ce que vous obtenez est un binaire masque et une boîte de bounding pour chaque image.

Voici les résultats en utilisant cette technique naïve:

Code sur MATLAB suit: Le code s'exécute sur un dossier avec des images JPG. Charge toutes les images et renvoie les résultats détectés.

% clear everything

clear;

pack;

close all;

close all hidden;

drawnow;

clc;

% initialization

ims=dir('./*.jpg');

imgs={};

images={};

blur_images={};

log_image={};

dilated_image={};

int_image={};

bin_image={};

measurements={};

box={};

num=length(ims);

thres_div = 3;

for i=1:num,

% load original image

imgs{end+1}=imread(ims(i).name);

% convert to grayscale

images{end+1}=rgb2gray(imgs{i});

% apply laplacian filtering and heuristic hard thresholding

val_thres = (max(max(images{i}))/thres_div);

log_image{end+1} = imfilter( images{i},fspecial('log')) > val_thres;

% get the most bright regions of the image

int_thres = 0.26*max(max( images{i}));

int_image{end+1} = images{i} > int_thres;

% compute the final binary image by combining

% high 'activity' with high intensity

bin_image{end+1} = log_image{i} .* int_image{i};

% apply morphological dilation to connect distonnected components

strel_size = round(0.01*max(size(imgs{i}))); % structuring element for morphological dilation

dilated_image{end+1} = imdilate( bin_image{i}, strel('disk',strel_size));

% do some measurements to eliminate small objects

measurements{i} = regionprops( logical( dilated_image{i}),'Area','BoundingBox');

for m=1:length(measurements{i})

if measurements{i}(m).Area < 0.05*numel( dilated_image{i})

dilated_image{i}( round(measurements{i}(m).BoundingBox(2):measurements{i}(m).BoundingBox(4)+measurements{i}(m).BoundingBox(2)),...

round(measurements{i}(m).BoundingBox(1):measurements{i}(m).BoundingBox(3)+measurements{i}(m).BoundingBox(1))) = 0;

end

end

% make sure the dilated image is the same size with the original

dilated_image{i} = dilated_image{i}(1:size(imgs{i},1),1:size(imgs{i},2));

% compute the bounding box

[y,x] = find( dilated_image{i});

if isempty( y)

box{end+1}=[];

else

box{end+1} = [ min(x) min(y) max(x)-min(x)+1 max(y)-min(y)+1];

end

end

%%% additional code to display things

for i=1:num,

figure;

subplot(121);

colormap gray;

imshow( imgs{i});

if ~isempty(box{i})

hold on;

rr = rectangle( 'position', box{i});

set( rr, 'EdgeColor', 'r');

hold off;

end

subplot(122);

imshow( imgs{i}.*uint8(repmat(dilated_image{i},[1 1 3])));

end

en utilisant une approche très différente de ce que j'ai vu, j'ai créé un script php qui détecte les arbres de Noël par leurs lumières. Le résultat est toujours un triangle symétrique, et si nécessaire des valeurs numériques comme l'angle ("fatness") de l'arbre.

la plus grande menace pour cet algorithme évidemment sont les lumières à côté (en grand nombre) ou en face de l'arbre (le plus grand problème jusqu'à une optimisation ultérieure). Modifier( ajouté): ce qu'il ne peut pas faire: Découvrez s'il y a un arbre de Noël ou non, trouvez plusieurs arbres de Noël dans une image, détectez correctement un arbre de Noël au milieu de Las Vegas, détectez les arbres de Noël qui sont fortement courbés, à l'envers ou coupés... ;)

les différentes étapes sont:

- calculer la luminosité ajoutée (R+G+B) pour chaque pixel

- additionnez cette valeur des 8 pixels voisins sur le dessus de chaque pixel

- classe tous les pixels par cette valeur (la plus brillante d'abord) - je sais, pas vraiment subtile...

- choisissez N de ceux-ci, à partir du haut, en sautant ceux qui sont trop proches

- calculer la médiane de ces top N (nous donne le centre approximatif de l'arbre)

- démarrer à partir de la position médiane vers le haut dans un faisceau de recherche d'élargissement pour la lumière la plus élevée parmi les plus brillants sélectionnés (les gens ont tendance à mettez au moins un feu en haut)

- de là, imaginez des lignes allant de 60 degrés à gauche et à droite vers le bas (les arbres de Noël ne devraient pas être si gras)

- diminuez ces 60 degrés jusqu'à ce que 20% des lumières les plus brillantes soient à l'extérieur de ce triangle.

- trouvez la lumière au bas du triangle, vous donnant le bord horizontal inférieur de l'arbre

- fait

Explication des inscriptions:

- Grand croix rouge dans le centre de l'arbre: la Médiane des N premiers les plus brillantes lumières

- ligne pointillée à partir de là vers le haut:" faisceau de recherche "pour le haut de l'arbre

- petite croix rouge: haut de l'arbre

- très petites croix rouges: toutes les lumières les plus brillantes du top N

- triangle rouge: d'uh!

code Source:

<?php

ini_set('memory_limit', '1024M');

header("Content-type: image/png");

$chosenImage = 6;

switch($chosenImage){

case 1:

$inputImage = imagecreatefromjpeg("nmzwj.jpg");

break;

case 2:

$inputImage = imagecreatefromjpeg("2y4o5.jpg");

break;

case 3:

$inputImage = imagecreatefromjpeg("YowlH.jpg");

break;

case 4:

$inputImage = imagecreatefromjpeg("2K9Ef.jpg");

break;

case 5:

$inputImage = imagecreatefromjpeg("aVZhC.jpg");

break;

case 6:

$inputImage = imagecreatefromjpeg("FWhSP.jpg");

break;

case 7:

$inputImage = imagecreatefromjpeg("roemerberg.jpg");

break;

default:

exit();

}

// Process the loaded image

$topNspots = processImage($inputImage);

imagejpeg($inputImage);

imagedestroy($inputImage);

// Here be functions

function processImage($image) {

$orange = imagecolorallocate($image, 220, 210, 60);

$black = imagecolorallocate($image, 0, 0, 0);

$red = imagecolorallocate($image, 255, 0, 0);

$maxX = imagesx($image)-1;

$maxY = imagesy($image)-1;

// Parameters

$spread = 1; // Number of pixels to each direction that will be added up

$topPositions = 80; // Number of (brightest) lights taken into account

$minLightDistance = round(min(array($maxX, $maxY)) / 30); // Minimum number of pixels between the brigtests lights

$searchYperX = 5; // spread of the "search beam" from the median point to the top

$renderStage = 3; // 1 to 3; exits the process early

// STAGE 1

// Calculate the brightness of each pixel (R+G+B)

$maxBrightness = 0;

$stage1array = array();

for($row = 0; $row <= $maxY; $row++) {

$stage1array[$row] = array();

for($col = 0; $col <= $maxX; $col++) {

$rgb = imagecolorat($image, $col, $row);

$brightness = getBrightnessFromRgb($rgb);

$stage1array[$row][$col] = $brightness;

if($renderStage == 1){

$brightnessToGrey = round($brightness / 765 * 256);

$greyRgb = imagecolorallocate($image, $brightnessToGrey, $brightnessToGrey, $brightnessToGrey);

imagesetpixel($image, $col, $row, $greyRgb);

}

if($brightness > $maxBrightness) {

$maxBrightness = $brightness;

if($renderStage == 1){

imagesetpixel($image, $col, $row, $red);

}

}

}

}

if($renderStage == 1) {

return;

}

// STAGE 2

// Add up brightness of neighbouring pixels

$stage2array = array();

$maxStage2 = 0;

for($row = 0; $row <= $maxY; $row++) {

$stage2array[$row] = array();

for($col = 0; $col <= $maxX; $col++) {

if(!isset($stage2array[$row][$col])) $stage2array[$row][$col] = 0;

// Look around the current pixel, add brightness

for($y = $row-$spread; $y <= $row+$spread; $y++) {

for($x = $col-$spread; $x <= $col+$spread; $x++) {

// Don't read values from outside the image

if($x >= 0 && $x <= $maxX && $y >= 0 && $y <= $maxY){

$stage2array[$row][$col] += $stage1array[$y][$x]+10;

}

}

}

$stage2value = $stage2array[$row][$col];

if($stage2value > $maxStage2) {

$maxStage2 = $stage2value;

}

}

}

if($renderStage >= 2){

// Paint the accumulated light, dimmed by the maximum value from stage 2

for($row = 0; $row <= $maxY; $row++) {

for($col = 0; $col <= $maxX; $col++) {

$brightness = round($stage2array[$row][$col] / $maxStage2 * 255);

$greyRgb = imagecolorallocate($image, $brightness, $brightness, $brightness);

imagesetpixel($image, $col, $row, $greyRgb);

}

}

}

if($renderStage == 2) {

return;

}

// STAGE 3

// Create a ranking of bright spots (like "Top 20")

$topN = array();

for($row = 0; $row <= $maxY; $row++) {

for($col = 0; $col <= $maxX; $col++) {

$stage2Brightness = $stage2array[$row][$col];

$topN[$col.":".$row] = $stage2Brightness;

}

}

arsort($topN);

$topNused = array();

$topPositionCountdown = $topPositions;

if($renderStage == 3){

foreach ($topN as $key => $val) {

if($topPositionCountdown <= 0){

break;

}

$position = explode(":", $key);

foreach($topNused as $usedPosition => $usedValue) {

$usedPosition = explode(":", $usedPosition);

$distance = abs($usedPosition[0] - $position[0]) + abs($usedPosition[1] - $position[1]);

if($distance < $minLightDistance) {

continue 2;

}

}

$topNused[$key] = $val;

paintCrosshair($image, $position[0], $position[1], $red, 2);

$topPositionCountdown--;

}

}

// STAGE 4

// Median of all Top N lights

$topNxValues = array();

$topNyValues = array();

foreach ($topNused as $key => $val) {

$position = explode(":", $key);

array_push($topNxValues, $position[0]);

array_push($topNyValues, $position[1]);

}

$medianXvalue = round(calculate_median($topNxValues));

$medianYvalue = round(calculate_median($topNyValues));

paintCrosshair($image, $medianXvalue, $medianYvalue, $red, 15);

// STAGE 5

// Find treetop

$filename = 'debug.log';

$handle = fopen($filename, "w");

fwrite($handle, "\n\n STAGE 5");

$treetopX = $medianXvalue;

$treetopY = $medianYvalue;

$searchXmin = $medianXvalue;

$searchXmax = $medianXvalue;

$width = 0;

for($y = $medianYvalue; $y >= 0; $y--) {

fwrite($handle, "\nAt y = ".$y);

if(($y % $searchYperX) == 0) { // Modulo

$width++;

$searchXmin = $medianXvalue - $width;

$searchXmax = $medianXvalue + $width;

imagesetpixel($image, $searchXmin, $y, $red);

imagesetpixel($image, $searchXmax, $y, $red);

}

foreach ($topNused as $key => $val) {

$position = explode(":", $key); // "x:y"

if($position[1] != $y){

continue;

}

if($position[0] >= $searchXmin && $position[0] <= $searchXmax){

$treetopX = $position[0];

$treetopY = $y;

}

}

}

paintCrosshair($image, $treetopX, $treetopY, $red, 5);

// STAGE 6

// Find tree sides

fwrite($handle, "\n\n STAGE 6");

$treesideAngle = 60; // The extremely "fat" end of a christmas tree

$treeBottomY = $treetopY;

$topPositionsExcluded = 0;

$xymultiplier = 0;

while(($topPositionsExcluded < ($topPositions / 5)) && $treesideAngle >= 1){

fwrite($handle, "\n\nWe're at angle ".$treesideAngle);

$xymultiplier = sin(deg2rad($treesideAngle));

fwrite($handle, "\nMultiplier: ".$xymultiplier);

$topPositionsExcluded = 0;

foreach ($topNused as $key => $val) {

$position = explode(":", $key);

fwrite($handle, "\nAt position ".$key);

if($position[1] > $treeBottomY) {

$treeBottomY = $position[1];

}

// Lights above the tree are outside of it, but don't matter

if($position[1] < $treetopY){

$topPositionsExcluded++;

fwrite($handle, "\nTOO HIGH");

continue;

}

// Top light will generate division by zero

if($treetopY-$position[1] == 0) {

fwrite($handle, "\nDIVISION BY ZERO");

continue;

}

// Lights left end right of it are also not inside

fwrite($handle, "\nLight position factor: ".(abs($treetopX-$position[0]) / abs($treetopY-$position[1])));

if((abs($treetopX-$position[0]) / abs($treetopY-$position[1])) > $xymultiplier){

$topPositionsExcluded++;

fwrite($handle, "\n --- Outside tree ---");

}

}

$treesideAngle--;

}

fclose($handle);

// Paint tree's outline

$treeHeight = abs($treetopY-$treeBottomY);

$treeBottomLeft = 0;

$treeBottomRight = 0;

$previousState = false; // line has not started; assumes the tree does not "leave"^^

for($x = 0; $x <= $maxX; $x++){

if(abs($treetopX-$x) != 0 && abs($treetopX-$x) / $treeHeight > $xymultiplier){

if($previousState == true){

$treeBottomRight = $x;

$previousState = false;

}

continue;

}

imagesetpixel($image, $x, $treeBottomY, $red);

if($previousState == false){

$treeBottomLeft = $x;

$previousState = true;

}

}

imageline($image, $treeBottomLeft, $treeBottomY, $treetopX, $treetopY, $red);

imageline($image, $treeBottomRight, $treeBottomY, $treetopX, $treetopY, $red);

// Print out some parameters

$string = "Min dist: ".$minLightDistance." | Tree angle: ".$treesideAngle." deg | Tree bottom: ".$treeBottomY;

$px = (imagesx($image) - 6.5 * strlen($string)) / 2;

imagestring($image, 2, $px, 5, $string, $orange);

return $topN;

}

/**

* Returns values from 0 to 765

*/

function getBrightnessFromRgb($rgb) {

$r = ($rgb >> 16) & 0xFF;

$g = ($rgb >> 8) & 0xFF;

$b = $rgb & 0xFF;

return $r+$r+$b;

}

function paintCrosshair($image, $posX, $posY, $color, $size=5) {

for($x = $posX-$size; $x <= $posX+$size; $x++) {

if($x>=0 && $x < imagesx($image)){

imagesetpixel($image, $x, $posY, $color);

}

}

for($y = $posY-$size; $y <= $posY+$size; $y++) {

if($y>=0 && $y < imagesy($image)){

imagesetpixel($image, $posX, $y, $color);

}

}

}

// From http://www.mdj.us/web-development/php-programming/calculating-the-median-average-values-of-an-array-with-php/

function calculate_median($arr) {

sort($arr);

$count = count($arr); //total numbers in array

$middleval = floor(($count-1)/2); // find the middle value, or the lowest middle value

if($count % 2) { // odd number, middle is the median

$median = $arr[$middleval];

} else { // even number, calculate avg of 2 medians

$low = $arr[$middleval];

$high = $arr[$middleval+1];

$median = (($low+$high)/2);

}

return $median;

}

?>

Images:

Bonus: un Weihnachtsbaum allemand, de Wikipedia

http://commons.wikimedia.org/wiki/File:Weihnachtsbaum_R%C3%B6merberg.jpg

http://commons.wikimedia.org/wiki/File:Weihnachtsbaum_R%C3%B6merberg.jpg

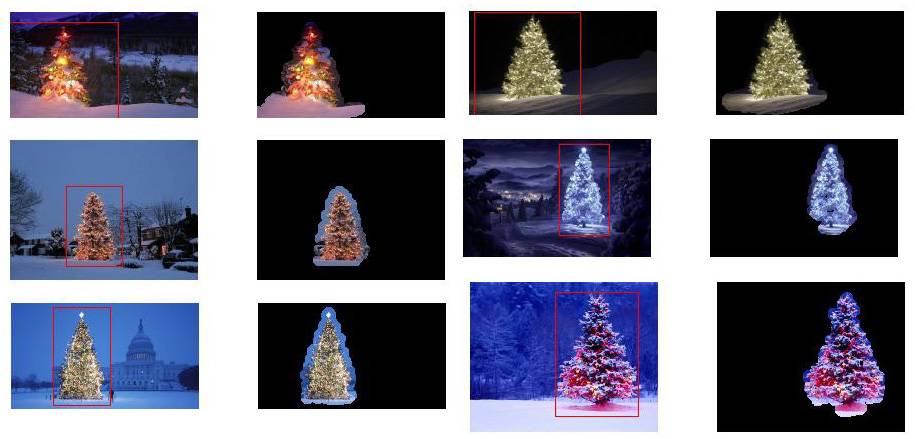

j'ai utilisé python avec opencv.

mon algorithme fait comme ceci:

- D'abord il prend le canal rouge de l'image

- Appliquer un seuil (valeur min 200) pour le canal Rouge

- ensuite appliquer un Gradient morphologique et ensuite faire une "fermeture" (dilatation suivie d'érosion)

- puis il trouve les contours dans le plan et il choisit le contour le plus long.

le code:

import numpy as np

import cv2

import copy

def findTree(image,num):

im = cv2.imread(image)

im = cv2.resize(im, (400,250))

gray = cv2.cvtColor(im, cv2.COLOR_RGB2GRAY)

imf = copy.deepcopy(im)

b,g,r = cv2.split(im)

minR = 200

_,thresh = cv2.threshold(r,minR,255,0)

kernel = np.ones((25,5))

dst = cv2.morphologyEx(thresh, cv2.MORPH_GRADIENT, kernel)

dst = cv2.morphologyEx(dst, cv2.MORPH_CLOSE, kernel)

contours = cv2.findContours(dst,cv2.RETR_TREE,cv2.CHAIN_APPROX_SIMPLE)[0]

cv2.drawContours(im, contours,-1, (0,255,0), 1)

maxI = 0

for i in range(len(contours)):

if len(contours[maxI]) < len(contours[i]):

maxI = i

img = copy.deepcopy(r)

cv2.polylines(img,[contours[maxI]],True,(255,255,255),3)

imf[:,:,2] = img

cv2.imshow(str(num), imf)

def main():

findTree('tree.jpg',1)

findTree('tree2.jpg',2)

findTree('tree3.jpg',3)

findTree('tree4.jpg',4)

findTree('tree5.jpg',5)

findTree('tree6.jpg',6)

cv2.waitKey(0)

cv2.destroyAllWindows()

if __name__ == "__main__":

main()

Si je change le noyau de (25,5) (10,5)

J'obtiens de meilleurs résultats sur tous les arbres mais en bas à gauche,

mon algorithme suppose que l'arbre a des lumières sur elle, et dans l'arbre en bas à gauche, le haut a moins de lumière que les autres.