Comment vérifier la version Spark

comme intitulé, Comment puis-je savoir quelle version de spark a été installée dans les CentOS?

Le système actuel a installé cdh5.1.0.

9 réponses

si vous utilisez Spark-Shell, il apparaît dans la bannière au début.

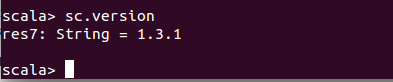

par programmation, SparkContext.version peut être utilisé.

Vous pouvez utiliser la commande spark-submit:

spark-submit --version

Dans Spark 2.programme x/shell,

spark.version

Où spark variable SparkSession objet

en utilisant les logs de la console au début de spark-shell

[root@bdhost001 ~]$ spark-shell

Setting default log level to "WARN".

To adjust logging level use sc.setLogLevel(newLevel).

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 2.2.0

/_/

sans entrer dans le code / shell

spark-shell --version

[root@bdhost001 ~]$ spark-shell --version

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 2.2.0

/_/

Type --help for more information.

spark-submit --version

[root@bdhost001 ~]$ spark-submit --version

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 2.2.0

/_/

Type --help for more information.

si vous utilisez des Databricks et que vous parlez à un notebook, exécutez simplement:

spark.version

quelle que soit la commande shell que vous utilisez, spark-shell ou pyspark, il atterrira sur un Logo Spark avec un nom de version à côté.

$ pyspark

$ Python 2.6.6 (r266: 84292, 22 mai 2015, 08: 34:51)

[GCC 4.4.7 20120313( Red Hat 4.4.7-15)] sur linux2

............

...........

Bienvenue à

la version 1.3.0

Utilisez ci-dessous pour obtenir la version spark

spark-submit --version

si vous utilisez pyspark, la version spark utilisée peut être vue à côté du logo Bold Spark comme suit:

manoj@hadoop-host:~$ pyspark

Python 2.7.6 (default, Jun 22 2015, 17:58:13)

[GCC 4.8.2] on linux2

Type "help", "copyright", "credits" or "license" for more information.

Setting default log level to "WARN".

To adjust logging level use sc.setLogLevel(newLevel).

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/__ / .__/\_,_/_/ /_/\_\ version 1.6.0

/_/

Using Python version 2.7.6 (default, Jun 22 2015 17:58:13)

SparkContext available as sc, HiveContext available as sqlContext.

>>>

si vous voulez obtenir la version spark explicitement, vous pouvez utiliser la méthode de version de SparkContext comme indiqué ci-dessous:

>>>

>>> sc.version

u'1.6.0'

>>>

Si vous êtes sur cahier Zeppelin vous pouvez exécuter:

sc.version

pour connaître la version scala ainsi vous pouvez ran:

util.Properties.versionString