Comment faire pour dupliquer sys.stdout à un fichier log en python?

Edit: Puisqu'il semble qu'il n'y ait pas de solution, ou que je fasse quelque chose de tellement non standard que personne ne sait-je vais réviser ma question pour aussi me demander: Quelle est la meilleure façon d'accomplir la journalisation quand une application python fait beaucoup d'appels système?

mon application a deux modes. En mode interactif, je veux que toute la sortie aille à l'écran ainsi qu'à un fichier journal, y compris la sortie de tous les appels système. En mode démon, toute la sortie va au log. Mode démon fonctionne très bien en utilisant os.dup2() . Je n'arrive pas à trouver un moyen de" lancer " toutes les sorties vers une log en mode interactif, sans modifier chaque appel système.

en d'autres termes, je veux la fonctionnalité de la ligne de commande "tee" pour toute sortie générée par une application python, y compris la sortie d'appel système .

pour clarifier:

pour rediriger toute la sortie je fais quelque chose comme ça, et ça marche grand:

# open our log file

so = se = open("%s.log" % self.name, 'w', 0)

# re-open stdout without buffering

sys.stdout = os.fdopen(sys.stdout.fileno(), 'w', 0)

# redirect stdout and stderr to the log file opened above

os.dup2(so.fileno(), sys.stdout.fileno())

os.dup2(se.fileno(), sys.stderr.fileno())

la bonne chose à propos de ceci est qu'il ne nécessite pas d'appels Spéciaux d'impression du reste du code. Le code exécute également certaines commandes shell, il est donc agréable de ne pas avoir à traiter chaque sortie individuellement.

simplement, je veux faire la même chose, sauf duplication au lieu de rediriger.

à première vue, j'ai pensé que simplement inverser le dup2 ' S devrait travail. Pourquoi n'est-ce pas? Voici mon test:

import os, sys

### my broken solution:

so = se = open("a.log", 'w', 0)

sys.stdout = os.fdopen(sys.stdout.fileno(), 'w', 0)

os.dup2(sys.stdout.fileno(), so.fileno())

os.dup2(sys.stderr.fileno(), se.fileno())

###

print("foo bar")

os.spawnve("P_WAIT", "/bin/ls", ["/bin/ls"], {})

os.execve("/bin/ls", ["/bin/ls"], os.environ)

Le fichier ".journal" doit être identique à ce qui était affiché sur l'écran.

15 réponses

puisque vous êtes à l'aise avec les processus externes de votre code, vous pouvez utiliser tee lui-même. Je ne connais pas D'appels Unix qui font exactement ce que tee fait.

import subprocess, os, sys

# Unbuffer output

sys.stdout = os.fdopen(sys.stdout.fileno(), 'w', 0)

tee = subprocess.Popen(["tee", "log.txt"], stdin=subprocess.PIPE)

os.dup2(tee.stdin.fileno(), sys.stdout.fileno())

os.dup2(tee.stdin.fileno(), sys.stderr.fileno())

print "\nstdout"

print >>sys.stderr, "stderr"

os.spawnve("P_WAIT", "/bin/ls", ["/bin/ls"], {})

os.execve("/bin/ls", ["/bin/ls"], os.environ)

vous pouvez également émuler tee en utilisant le paquet multiprocessing (ou utiliser processing si vous utilisez Python 2.5 ou plus tôt).

j'ai déjà eu ce même problème et j'ai trouvé cet extrait très utile:

class Tee(object):

def __init__(self, name, mode):

self.file = open(name, mode)

self.stdout = sys.stdout

sys.stdout = self

def __del__(self):

sys.stdout = self.stdout

self.file.close()

def write(self, data):

self.file.write(data)

self.stdout.write(data)

def flush(self):

self.file.flush()

de: http://mail.python.org/pipermail/python-list/2007-May/438106.html

l'instruction print appellera la méthode write() de tout objet que vous assignez à sys.la sortie standard stdout.

je lancerais une petite classe pour écrire à deux endroits à la fois...

import sys

class Logger(object):

def __init__(self):

self.terminal = sys.stdout

self.log = open("log.dat", "a")

def write(self, message):

self.terminal.write(message)

self.log.write(message)

sys.stdout = Logger()

maintenant l'énoncé print fera à la fois écho à l'écran et sera ajouté à votre fichier journal:

# prints "1 2" to <stdout> AND log.dat

print "%d %d" % (1,2)

C'est évidemment rapide et sale. Quelques notes:

- vous devriez probablement paramétiser le nom de fichier log.

- vous devriez probablement Inverser sys.stdout à

<stdout>si vous ne pas se connecter pendant la durée du programme. - vous pouvez vouloir la capacité d'écrire dans plusieurs fichiers journaux à la fois, ou gérer différents niveaux de journaux, etc.

ils sont tous assez simples que je suis à l'aise de les laisser comme exercices pour le lecteur. L'idée clé ici est que print appelle simplement un "fichier-comme objet" est attribué à sys.stdout .

ce que vous voulez vraiment est le module logging de la bibliothèque standard. Créez un logger et attachez deux gestionnaires, l'un écrirait à un fichier et l'autre à stdout ou stderr.

voir exploitation forestière vers plusieurs destinations pour plus de détails

Voici une autre solution, qui est plus générale que les autres -- elle prend en charge la séparation de la sortie (écrite en sys.stdout ) vers n'importe quel nombre d'objets ressemblant à des fichiers. Il n'y a aucune exigence que __stdout__ lui-même soit inclus.

import sys

class multifile(object):

def __init__(self, files):

self._files = files

def __getattr__(self, attr, *args):

return self._wrap(attr, *args)

def _wrap(self, attr, *args):

def g(*a, **kw):

for f in self._files:

res = getattr(f, attr, *args)(*a, **kw)

return res

return g

# for a tee-like behavior, use like this:

sys.stdout = multifile([ sys.stdout, open('myfile.txt', 'w') ])

# all these forms work:

print 'abc'

print >>sys.stdout, 'line2'

sys.stdout.write('line3\n')

NOTE: il s'agit d'une validation de principe. L'implémentation ici n'est pas complète, car elle ne fait qu'envelopper les méthodes des objets ressemblant à des fichiers (par exemple write ), en laissant de côté les membres/propriétés/setattr, etc. Cependant, il est probablement assez bon pour la plupart des gens tel qu'il est actuellement.

ce que j'aime à son sujet, autre que sa généralité, est qu'il est propre dans le sens où il ne fait aucun appel direct à write , flush , os.dup2 , etc.

comme décrit ailleurs, la meilleure solution est peut-être d'utiliser directement le module de journalisation:

import logging

logging.basicConfig(level=logging.DEBUG, filename='mylog.log')

logging.info('this should to write to the log file')

cependant, il y a certaines occasions (rares) où vous voulez vraiment pour rediriger stdout. J'ai eu cette situation quand j'ai étendu la commande runserver de django qui utilise print: Je ne voulais pas pirater la source de django mais j'avais besoin des instructions d'impression pour aller dans un fichier.

C'est une façon de rediriger stdout et stderr s'éloigne du shell en utilisant le module de journalisation:

import logging, sys

class LogFile(object):

"""File-like object to log text using the `logging` module."""

def __init__(self, name=None):

self.logger = logging.getLogger(name)

def write(self, msg, level=logging.INFO):

self.logger.log(level, msg)

def flush(self):

for handler in self.logger.handlers:

handler.flush()

logging.basicConfig(level=logging.DEBUG, filename='mylog.log')

# Redirect stdout and stderr

sys.stdout = LogFile('stdout')

sys.stderr = LogFile('stderr')

print 'this should to write to the log file'

vous ne devez utiliser cette implémentation LogFile que si vous ne pouvez pas utiliser le module de journalisation directement.

j'ai écrit une implémentation tee() en Python qui devrait fonctionner dans la plupart des cas, et qui fonctionne aussi sous Windows.

https://github.com/pycontribs/tendo

aussi, vous pouvez l'utiliser en combinaison avec le module logging de Python Si vous voulez.

(Ah, il suffit de relire votre question et voir que cela ne s'applique pas tout à fait.)

Voici un exemple de programme qui utilise les python module de journalisation . Ce module de journalisation est dans toutes les versions depuis 2.3. Dans cet exemple, la journalisation est configurable par les options de ligne de commande.

En très mode, il ne journal de, en mode normal, il va se connecter à un fichier et le console.

import os

import sys

import logging

from optparse import OptionParser

def initialize_logging(options):

""" Log information based upon users options"""

logger = logging.getLogger('project')

formatter = logging.Formatter('%(asctime)s %(levelname)s\t%(message)s')

level = logging.__dict__.get(options.loglevel.upper(),logging.DEBUG)

logger.setLevel(level)

# Output logging information to screen

if not options.quiet:

hdlr = logging.StreamHandler(sys.stderr)

hdlr.setFormatter(formatter)

logger.addHandler(hdlr)

# Output logging information to file

logfile = os.path.join(options.logdir, "project.log")

if options.clean and os.path.isfile(logfile):

os.remove(logfile)

hdlr2 = logging.FileHandler(logfile)

hdlr2.setFormatter(formatter)

logger.addHandler(hdlr2)

return logger

def main(argv=None):

if argv is None:

argv = sys.argv[1:]

# Setup command line options

parser = OptionParser("usage: %prog [options]")

parser.add_option("-l", "--logdir", dest="logdir", default=".", help="log DIRECTORY (default ./)")

parser.add_option("-v", "--loglevel", dest="loglevel", default="debug", help="logging level (debug, info, error)")

parser.add_option("-q", "--quiet", action="store_true", dest="quiet", help="do not log to console")

parser.add_option("-c", "--clean", dest="clean", action="store_true", default=False, help="remove old log file")

# Process command line options

(options, args) = parser.parse_args(argv)

# Setup logger format and output locations

logger = initialize_logging(options)

# Examples

logger.error("This is an error message.")

logger.info("This is an info message.")

logger.debug("This is a debug message.")

if __name__ == "__main__":

sys.exit(main())

pour compléter la réponse de Jean T: https://stackoverflow.com/a/616686/395687

j'ai ajouté __enter__ et __exit__ méthodes pour l'utiliser comme un gestionnaire de contexte avec le mot-clé with , qui donne ce code

class Tee(object):

def __init__(self, name, mode):

self.file = open(name, mode)

self.stdout = sys.stdout

sys.stdout = self

def __del__(self):

sys.stdout = self.stdout

self.file.close()

def write(self, data):

self.file.write(data)

self.stdout.write(data)

def __enter__(self):

pass

def __exit__(self, _type, _value, _traceback):

pass

Il peut alors être utilisé comme

with Tee('outfile.log', 'w'):

print('I am written to both stdout and outfile.log')

une autre solution utilisant un module de journalisation:

import logging

import sys

log = logging.getLogger('stdxxx')

class StreamLogger(object):

def __init__(self, stream, prefix=''):

self.stream = stream

self.prefix = prefix

self.data = ''

def write(self, data):

self.stream.write(data)

self.stream.flush()

self.data += data

tmp = str(self.data)

if '\x0a' in tmp or '\x0d' in tmp:

tmp = tmp.rstrip('\x0a\x0d')

log.info('%s%s' % (self.prefix, tmp))

self.data = ''

logging.basicConfig(level=logging.INFO,

filename='text.log',

filemode='a')

sys.stdout = StreamLogger(sys.stdout, '[stdout] ')

print 'test for stdout'

aucune des réponses ci-dessus ne semble vraiment répondre au problème posé. Je sais que c'est un vieux fil, mais je pense que ce problème est beaucoup plus simple que tout le monde le fait:

class tee_err(object):

def __init__(self):

self.errout = sys.stderr

sys.stderr = self

self.log = 'logfile.log'

log = open(self.log,'w')

log.close()

def write(self, line):

log = open(self.log,'a')

log.write(line)

log.close()

self.errout.write(line)

maintenant cela va tout répéter au système normal.stderr handler et votre dossier. Créer une autre classe tee_out pour sys.stdout .

je sais que cette question a été répondue à plusieurs reprises, mais pour cela j'ai pris la réponse principale de John T réponse et modifié de sorte qu'il contient le flush suggéré et a suivi sa version révisée liée. J'ai aussi ajouté la réponse "entrer et sortir" comme indiqué dans cladmi à utiliser avec l'instruction with. En outre, la documentation mentionne de rincer les fichiers en utilisant os.fsync() donc j'ai ajouté cela aussi. Je ne sais pas si vous vraiment besoin que, mais il est là.

import sys, os

class Logger(object):

"Lumberjack class - duplicates sys.stdout to a log file and it's okay"

#source: /q/how-do-i-duplicate-sys-stdout-to-a-log-file-in-python-35640/"Red.Wood", mode="a", buff=0):

self.stdout = sys.stdout

self.file = open(filename, mode, buff)

sys.stdout = self

def __del__(self):

self.close()

def __enter__(self):

pass

def __exit__(self, *args):

self.close()

def write(self, message):

self.stdout.write(message)

self.file.write(message)

def flush(self):

self.stdout.flush()

self.file.flush()

os.fsync(self.file.fileno())

def close(self):

if self.stdout != None:

sys.stdout = self.stdout

self.stdout = None

if self.file != None:

self.file.close()

self.file = None

vous pouvez alors l'utiliser

with Logger('My_best_girlie_by_my.side'):

print("we'd sing sing sing")

ou

Log=Logger('Sleeps_all.night')

print('works all day')

Log.close()

comme suite à une demande de @user5359531 dans les commentaires sous réponse de @John T , voici une copie du billet référencé à la version révisée de la discussion liée dans cette réponse:

Issue of redirecting the stdout to both file and screen

Gabriel Genellina gagsl-py2 at yahoo.com.ar

Mon May 28 12:45:51 CEST 2007

Previous message: Issue of redirecting the stdout to both file and screen

Next message: Formal interfaces with Python

Messages sorted by: [ date ] [ thread ] [ subject ] [ author ]

En Mon, 28 May 2007 06:17:39 -0300, 人言落日是天涯,望极天涯不见家

<kelvin.you at gmail.com> escribió:

> I wanna print the log to both the screen and file, so I simulatered a

> 'tee'

>

> class Tee(file):

>

> def __init__(self, name, mode):

> file.__init__(self, name, mode)

> self.stdout = sys.stdout

> sys.stdout = self

>

> def __del__(self):

> sys.stdout = self.stdout

> self.close()

>

> def write(self, data):

> file.write(self, data)

> self.stdout.write(data)

>

> Tee('logfile', 'w')

> print >>sys.stdout, 'abcdefg'

>

> I found that it only output to the file, nothing to screen. Why?

> It seems the 'write' function was not called when I *print* something.

You create a Tee instance and it is immediately garbage collected. I'd

restore sys.stdout on Tee.close, not __del__ (you forgot to call the

inherited __del__ method, btw).

Mmm, doesn't work. I think there is an optimization somewhere: if it looks

like a real file object, it uses the original file write method, not yours.

The trick would be to use an object that does NOT inherit from file:

import sys

class TeeNoFile(object):

def __init__(self, name, mode):

self.file = open(name, mode)

self.stdout = sys.stdout

sys.stdout = self

def close(self):

if self.stdout is not None:

sys.stdout = self.stdout

self.stdout = None

if self.file is not None:

self.file.close()

self.file = None

def write(self, data):

self.file.write(data)

self.stdout.write(data)

def flush(self):

self.file.flush()

self.stdout.flush()

def __del__(self):

self.close()

tee=TeeNoFile('logfile', 'w')

print 'abcdefg'

print 'another line'

tee.close()

print 'screen only'

del tee # should do nothing

--

Gabriel Genellina

j'écris un script pour exécuter des scripts cmd-line. ( Parce que dans certains cas, il n'y a tout simplement pas de substitut viable pour une commande Linux -- comme le cas de rsync. )

ce que je voulais vraiment était d'utiliser le mécanisme de journalisation python par défaut dans tous les cas où il était possible de le faire, mais de capturer quand même toute erreur quand quelque chose a mal tourné qui était imprévu.

Ce code semble faire l'affaire. Il peut ne pas être particulièrement élégant ou efficace (bien qu'il n'utilise pas string+ = string, donc au moins il n'a pas cette bouteille de potentiel particulière- cou.) Je le poste au cas où ça donnerait à quelqu'un d'autre des idées utiles.

import logging

import os, sys

import datetime

# Get name of module, use as application name

try:

ME=os.path.split(__file__)[-1].split('.')[0]

except:

ME='pyExec_'

LOG_IDENTIFIER="uuu___( o O )___uuu "

LOG_IDR_LENGTH=len(LOG_IDENTIFIER)

class PyExec(object):

# Use this to capture all possible error / output to log

class SuperTee(object):

# Original reference: http://mail.python.org/pipermail/python-list/2007-May/442737.html

def __init__(self, name, mode):

self.fl = open(name, mode)

self.fl.write('\n')

self.stdout = sys.stdout

self.stdout.write('\n')

self.stderr = sys.stderr

sys.stdout = self

sys.stderr = self

def __del__(self):

self.fl.write('\n')

self.fl.flush()

sys.stderr = self.stderr

sys.stdout = self.stdout

self.fl.close()

def write(self, data):

# If the data to write includes the log identifier prefix, then it is already formatted

if data[0:LOG_IDR_LENGTH]==LOG_IDENTIFIER:

self.fl.write("%s\n" % data[LOG_IDR_LENGTH:])

self.stdout.write(data[LOG_IDR_LENGTH:])

# Otherwise, we can give it a timestamp

else:

timestamp=str(datetime.datetime.now())

if 'Traceback' == data[0:9]:

data='%s: %s' % (timestamp, data)

self.fl.write(data)

else:

self.fl.write(data)

self.stdout.write(data)

def __init__(self, aName, aCmd, logFileName='', outFileName=''):

# Using name for 'logger' (context?), which is separate from the module or the function

baseFormatter=logging.Formatter("%(asctime)s \t %(levelname)s \t %(name)s:%(module)s:%(lineno)d \t %(message)s")

errorFormatter=logging.Formatter(LOG_IDENTIFIER + "%(asctime)s \t %(levelname)s \t %(name)s:%(module)s:%(lineno)d \t %(message)s")

if logFileName:

# open passed filename as append

fl=logging.FileHandler("%s.log" % aName)

else:

# otherwise, use log filename as a one-time use file

fl=logging.FileHandler("%s.log" % aName, 'w')

fl.setLevel(logging.DEBUG)

fl.setFormatter(baseFormatter)

# This will capture stdout and CRITICAL and beyond errors

if outFileName:

teeFile=PyExec.SuperTee("%s_out.log" % aName)

else:

teeFile=PyExec.SuperTee("%s_out.log" % aName, 'w')

fl_out=logging.StreamHandler( teeFile )

fl_out.setLevel(logging.CRITICAL)

fl_out.setFormatter(errorFormatter)

# Set up logging

self.log=logging.getLogger('pyExec_main')

log=self.log

log.addHandler(fl)

log.addHandler(fl_out)

print "Test print statement."

log.setLevel(logging.DEBUG)

log.info("Starting %s", ME)

log.critical("Critical.")

# Caught exception

try:

raise Exception('Exception test.')

except Exception,e:

log.exception(str(e))

# Uncaught exception

a=2/0

PyExec('test_pyExec',None)

évidemment, si vous n'êtes pas aussi sujet à la fantaisie que je le suis, remplacez LOG_IDENTIFIER par une autre chaîne de caractères que vous n'aimez pas voir quelqu'un écrire dans un journal de bord.

j'ai écrit un remplacement complet pour sys.stderr et je viens de dupliquer le code renommant stderr en stdout pour le rendre également disponible pour remplacer sys.stdout .

pour ce faire, je crée le même type d'objet que les actuels stderr et stdout , et transmet toutes les méthodes au système original stderr et stdout :

import os

import sys

import logging

class StdErrReplament(object):

"""

How to redirect stdout and stderr to logger in Python

/q/how-to-redirect-stdout-and-stderr-to-logger-in-python-52113/"""

is_active = False

@classmethod

def lock(cls, logger):

"""

Attach this singleton logger to the `sys.stderr` permanently.

"""

global _stderr_singleton

global _stderr_default

global _stderr_default_class_type

# On Sublime Text, `sys.__stderr__` is set to None, because they already replaced `sys.stderr`

# by some `_LogWriter()` class, then just save the current one over there.

if not sys.__stderr__:

sys.__stderr__ = sys.stderr

try:

_stderr_default

_stderr_default_class_type

except NameError:

_stderr_default = sys.stderr

_stderr_default_class_type = type( _stderr_default )

# Recreate the sys.stderr logger when it was reset by `unlock()`

if not cls.is_active:

cls.is_active = True

_stderr_write = _stderr_default.write

logger_call = logger.debug

clean_formatter = logger.clean_formatter

global _sys_stderr_write

global _sys_stderr_write_hidden

if sys.version_info <= (3,2):

logger.file_handler.terminator = '\n'

# Always recreate/override the internal write function used by `_sys_stderr_write`

def _sys_stderr_write_hidden(*args, **kwargs):

"""

Suppress newline in Python logging module

/q/suppress-newline-in-python-logging-module-10841/"""

try:

_stderr_write( *args, **kwargs )

file_handler = logger.file_handler

formatter = file_handler.formatter

terminator = file_handler.terminator

file_handler.formatter = clean_formatter

file_handler.terminator = ""

kwargs['extra'] = {'_duplicated_from_file': True}

logger_call( *args, **kwargs )

file_handler.formatter = formatter

file_handler.terminator = terminator

except Exception:

logger.exception( "Could not write to the file_handler: %s(%s)", file_handler, logger )

cls.unlock()

# Only create one `_sys_stderr_write` function pointer ever

try:

_sys_stderr_write

except NameError:

def _sys_stderr_write(*args, **kwargs):

"""

Hides the actual function pointer. This allow the external function pointer to

be cached while the internal written can be exchanged between the standard

`sys.stderr.write` and our custom wrapper around it.

"""

_sys_stderr_write_hidden( *args, **kwargs )

try:

# Only create one singleton instance ever

_stderr_singleton

except NameError:

class StdErrReplamentHidden(_stderr_default_class_type):

"""

Which special methods bypasses __getattribute__ in Python?

https://stackoverflow.com/questions/12872695/which-special-methods-bypasses-getattribute-in-python

"""

if hasattr( _stderr_default, "__abstractmethods__" ):

__abstractmethods__ = _stderr_default.__abstractmethods__

if hasattr( _stderr_default, "__base__" ):

__base__ = _stderr_default.__base__

if hasattr( _stderr_default, "__bases__" ):

__bases__ = _stderr_default.__bases__

if hasattr( _stderr_default, "__basicsize__" ):

__basicsize__ = _stderr_default.__basicsize__

if hasattr( _stderr_default, "__call__" ):

__call__ = _stderr_default.__call__

if hasattr( _stderr_default, "__class__" ):

__class__ = _stderr_default.__class__

if hasattr( _stderr_default, "__delattr__" ):

__delattr__ = _stderr_default.__delattr__

if hasattr( _stderr_default, "__dict__" ):

__dict__ = _stderr_default.__dict__

if hasattr( _stderr_default, "__dictoffset__" ):

__dictoffset__ = _stderr_default.__dictoffset__

if hasattr( _stderr_default, "__dir__" ):

__dir__ = _stderr_default.__dir__

if hasattr( _stderr_default, "__doc__" ):

__doc__ = _stderr_default.__doc__

if hasattr( _stderr_default, "__eq__" ):

__eq__ = _stderr_default.__eq__

if hasattr( _stderr_default, "__flags__" ):

__flags__ = _stderr_default.__flags__

if hasattr( _stderr_default, "__format__" ):

__format__ = _stderr_default.__format__

if hasattr( _stderr_default, "__ge__" ):

__ge__ = _stderr_default.__ge__

if hasattr( _stderr_default, "__getattribute__" ):

__getattribute__ = _stderr_default.__getattribute__

if hasattr( _stderr_default, "__gt__" ):

__gt__ = _stderr_default.__gt__

if hasattr( _stderr_default, "__hash__" ):

__hash__ = _stderr_default.__hash__

if hasattr( _stderr_default, "__init__" ):

__init__ = _stderr_default.__init__

if hasattr( _stderr_default, "__init_subclass__" ):

__init_subclass__ = _stderr_default.__init_subclass__

if hasattr( _stderr_default, "__instancecheck__" ):

__instancecheck__ = _stderr_default.__instancecheck__

if hasattr( _stderr_default, "__itemsize__" ):

__itemsize__ = _stderr_default.__itemsize__

if hasattr( _stderr_default, "__le__" ):

__le__ = _stderr_default.__le__

if hasattr( _stderr_default, "__lt__" ):

__lt__ = _stderr_default.__lt__

if hasattr( _stderr_default, "__module__" ):

__module__ = _stderr_default.__module__

if hasattr( _stderr_default, "__mro__" ):

__mro__ = _stderr_default.__mro__

if hasattr( _stderr_default, "__name__" ):

__name__ = _stderr_default.__name__

if hasattr( _stderr_default, "__ne__" ):

__ne__ = _stderr_default.__ne__

if hasattr( _stderr_default, "__new__" ):

__new__ = _stderr_default.__new__

if hasattr( _stderr_default, "__prepare__" ):

__prepare__ = _stderr_default.__prepare__

if hasattr( _stderr_default, "__qualname__" ):

__qualname__ = _stderr_default.__qualname__

if hasattr( _stderr_default, "__reduce__" ):

__reduce__ = _stderr_default.__reduce__

if hasattr( _stderr_default, "__reduce_ex__" ):

__reduce_ex__ = _stderr_default.__reduce_ex__

if hasattr( _stderr_default, "__repr__" ):

__repr__ = _stderr_default.__repr__

if hasattr( _stderr_default, "__setattr__" ):

__setattr__ = _stderr_default.__setattr__

if hasattr( _stderr_default, "__sizeof__" ):

__sizeof__ = _stderr_default.__sizeof__

if hasattr( _stderr_default, "__str__" ):

__str__ = _stderr_default.__str__

if hasattr( _stderr_default, "__subclasscheck__" ):

__subclasscheck__ = _stderr_default.__subclasscheck__

if hasattr( _stderr_default, "__subclasses__" ):

__subclasses__ = _stderr_default.__subclasses__

if hasattr( _stderr_default, "__subclasshook__" ):

__subclasshook__ = _stderr_default.__subclasshook__

if hasattr( _stderr_default, "__text_signature__" ):

__text_signature__ = _stderr_default.__text_signature__

if hasattr( _stderr_default, "__weakrefoffset__" ):

__weakrefoffset__ = _stderr_default.__weakrefoffset__

if hasattr( _stderr_default, "mro" ):

mro = _stderr_default.mro

def __init__(self):

"""

Override any super class `type( _stderr_default )` constructor, so we can

instantiate any kind of `sys.stderr` replacement object, in case it was already

replaced by something else like on Sublime Text with `_LogWriter()`.

Assures all attributes were statically replaced just above. This should happen in case

some new attribute is added to the python language.

This also ignores the only two methods which are not equal, `__init__()` and `__getattribute__()`.

"""

different_methods = ("__init__", "__getattribute__")

attributes_to_check = set( dir( object ) + dir( type ) )

for attribute in attributes_to_check:

if attribute not in different_methods \

and hasattr( _stderr_default, attribute ):

base_class_attribute = super( _stderr_default_class_type, self ).__getattribute__( attribute )

target_class_attribute = _stderr_default.__getattribute__( attribute )

if base_class_attribute != target_class_attribute:

sys.stderr.write( " The base class attribute `%s` is different from the target class:\n%s\n%s\n\n" % (

attribute, base_class_attribute, target_class_attribute ) )

def __getattribute__(self, item):

if item == 'write':

return _sys_stderr_write

try:

return _stderr_default.__getattribute__( item )

except AttributeError:

return super( _stderr_default_class_type, _stderr_default ).__getattribute__( item )

_stderr_singleton = StdErrReplamentHidden()

sys.stderr = _stderr_singleton

return cls

@classmethod

def unlock(cls):

"""

Detach this `stderr` writer from `sys.stderr` and allow the next call to `lock()` create

a new writer for the stderr.

"""

if cls.is_active:

global _sys_stderr_write_hidden

cls.is_active = False

_sys_stderr_write_hidden = _stderr_default.write

class StdOutReplament(object):

"""

How to redirect stdout and stderr to logger in Python

/q/how-to-redirect-stdout-and-stderr-to-logger-in-python-52113/"""

is_active = False

@classmethod

def lock(cls, logger):

"""

Attach this singleton logger to the `sys.stdout` permanently.

"""

global _stdout_singleton

global _stdout_default

global _stdout_default_class_type

# On Sublime Text, `sys.__stdout__` is set to None, because they already replaced `sys.stdout`

# by some `_LogWriter()` class, then just save the current one over there.

if not sys.__stdout__:

sys.__stdout__ = sys.stdout

try:

_stdout_default

_stdout_default_class_type

except NameError:

_stdout_default = sys.stdout

_stdout_default_class_type = type( _stdout_default )

# Recreate the sys.stdout logger when it was reset by `unlock()`

if not cls.is_active:

cls.is_active = True

_stdout_write = _stdout_default.write

logger_call = logger.debug

clean_formatter = logger.clean_formatter

global _sys_stdout_write

global _sys_stdout_write_hidden

if sys.version_info <= (3,2):

logger.file_handler.terminator = '\n'

# Always recreate/override the internal write function used by `_sys_stdout_write`

def _sys_stdout_write_hidden(*args, **kwargs):

"""

Suppress newline in Python logging module

/q/suppress-newline-in-python-logging-module-10841/"""

try:

_stdout_write( *args, **kwargs )

file_handler = logger.file_handler

formatter = file_handler.formatter

terminator = file_handler.terminator

file_handler.formatter = clean_formatter

file_handler.terminator = ""

kwargs['extra'] = {'_duplicated_from_file': True}

logger_call( *args, **kwargs )

file_handler.formatter = formatter

file_handler.terminator = terminator

except Exception:

logger.exception( "Could not write to the file_handler: %s(%s)", file_handler, logger )

cls.unlock()

# Only create one `_sys_stdout_write` function pointer ever

try:

_sys_stdout_write

except NameError:

def _sys_stdout_write(*args, **kwargs):

"""

Hides the actual function pointer. This allow the external function pointer to

be cached while the internal written can be exchanged between the standard

`sys.stdout.write` and our custom wrapper around it.

"""

_sys_stdout_write_hidden( *args, **kwargs )

try:

# Only create one singleton instance ever

_stdout_singleton

except NameError:

class StdOutReplamentHidden(_stdout_default_class_type):

"""

Which special methods bypasses __getattribute__ in Python?

https://stackoverflow.com/questions/12872695/which-special-methods-bypasses-getattribute-in-python

"""

if hasattr( _stdout_default, "__abstractmethods__" ):

__abstractmethods__ = _stdout_default.__abstractmethods__

if hasattr( _stdout_default, "__base__" ):

__base__ = _stdout_default.__base__

if hasattr( _stdout_default, "__bases__" ):

__bases__ = _stdout_default.__bases__

if hasattr( _stdout_default, "__basicsize__" ):

__basicsize__ = _stdout_default.__basicsize__

if hasattr( _stdout_default, "__call__" ):

__call__ = _stdout_default.__call__

if hasattr( _stdout_default, "__class__" ):

__class__ = _stdout_default.__class__

if hasattr( _stdout_default, "__delattr__" ):

__delattr__ = _stdout_default.__delattr__

if hasattr( _stdout_default, "__dict__" ):

__dict__ = _stdout_default.__dict__

if hasattr( _stdout_default, "__dictoffset__" ):

__dictoffset__ = _stdout_default.__dictoffset__

if hasattr( _stdout_default, "__dir__" ):

__dir__ = _stdout_default.__dir__

if hasattr( _stdout_default, "__doc__" ):

__doc__ = _stdout_default.__doc__

if hasattr( _stdout_default, "__eq__" ):

__eq__ = _stdout_default.__eq__

if hasattr( _stdout_default, "__flags__" ):

__flags__ = _stdout_default.__flags__

if hasattr( _stdout_default, "__format__" ):

__format__ = _stdout_default.__format__

if hasattr( _stdout_default, "__ge__" ):

__ge__ = _stdout_default.__ge__

if hasattr( _stdout_default, "__getattribute__" ):

__getattribute__ = _stdout_default.__getattribute__

if hasattr( _stdout_default, "__gt__" ):

__gt__ = _stdout_default.__gt__

if hasattr( _stdout_default, "__hash__" ):

__hash__ = _stdout_default.__hash__

if hasattr( _stdout_default, "__init__" ):

__init__ = _stdout_default.__init__

if hasattr( _stdout_default, "__init_subclass__" ):

__init_subclass__ = _stdout_default.__init_subclass__

if hasattr( _stdout_default, "__instancecheck__" ):

__instancecheck__ = _stdout_default.__instancecheck__

if hasattr( _stdout_default, "__itemsize__" ):

__itemsize__ = _stdout_default.__itemsize__

if hasattr( _stdout_default, "__le__" ):

__le__ = _stdout_default.__le__

if hasattr( _stdout_default, "__lt__" ):

__lt__ = _stdout_default.__lt__

if hasattr( _stdout_default, "__module__" ):

__module__ = _stdout_default.__module__

if hasattr( _stdout_default, "__mro__" ):

__mro__ = _stdout_default.__mro__

if hasattr( _stdout_default, "__name__" ):

__name__ = _stdout_default.__name__

if hasattr( _stdout_default, "__ne__" ):

__ne__ = _stdout_default.__ne__

if hasattr( _stdout_default, "__new__" ):

__new__ = _stdout_default.__new__

if hasattr( _stdout_default, "__prepare__" ):

__prepare__ = _stdout_default.__prepare__

if hasattr( _stdout_default, "__qualname__" ):

__qualname__ = _stdout_default.__qualname__

if hasattr( _stdout_default, "__reduce__" ):

__reduce__ = _stdout_default.__reduce__

if hasattr( _stdout_default, "__reduce_ex__" ):

__reduce_ex__ = _stdout_default.__reduce_ex__

if hasattr( _stdout_default, "__repr__" ):

__repr__ = _stdout_default.__repr__

if hasattr( _stdout_default, "__setattr__" ):

__setattr__ = _stdout_default.__setattr__

if hasattr( _stdout_default, "__sizeof__" ):

__sizeof__ = _stdout_default.__sizeof__

if hasattr( _stdout_default, "__str__" ):

__str__ = _stdout_default.__str__

if hasattr( _stdout_default, "__subclasscheck__" ):

__subclasscheck__ = _stdout_default.__subclasscheck__

if hasattr( _stdout_default, "__subclasses__" ):

__subclasses__ = _stdout_default.__subclasses__

if hasattr( _stdout_default, "__subclasshook__" ):

__subclasshook__ = _stdout_default.__subclasshook__

if hasattr( _stdout_default, "__text_signature__" ):

__text_signature__ = _stdout_default.__text_signature__

if hasattr( _stdout_default, "__weakrefoffset__" ):

__weakrefoffset__ = _stdout_default.__weakrefoffset__

if hasattr( _stdout_default, "mro" ):

mro = _stdout_default.mro

def __init__(self):

"""

Override any super class `type( _stdout_default )` constructor, so we can

instantiate any kind of `sys.stdout` replacement object, in case it was already

replaced by something else like on Sublime Text with `_LogWriter()`.

Assures all attributes were statically replaced just above. This should happen in case

some new attribute is added to the python language.

This also ignores the only two methods which are not equal, `__init__()` and `__getattribute__()`.

"""

different_methods = ("__init__", "__getattribute__")

attributes_to_check = set( dir( object ) + dir( type ) )

for attribute in attributes_to_check:

if attribute not in different_methods \

and hasattr( _stdout_default, attribute ):

base_class_attribute = super( _stdout_default_class_type, self ).__getattribute__( attribute )

target_class_attribute = _stdout_default.__getattribute__( attribute )

if base_class_attribute != target_class_attribute:

sys.stdout.write( " The base class attribute `%s` is different from the target class:\n%s\n%s\n\n" % (

attribute, base_class_attribute, target_class_attribute ) )

def __getattribute__(self, item):

if item == 'write':

return _sys_stdout_write

try:

return _stdout_default.__getattribute__( item )

except AttributeError:

return super( _stdout_default_class_type, _stdout_default ).__getattribute__( item )

_stdout_singleton = StdOutReplamentHidden()

sys.stdout = _stdout_singleton

return cls

@classmethod

def unlock(cls):

"""

Detach this `stdout` writer from `sys.stdout` and allow the next call to `lock()` create

a new writer for the stdout.

"""

if cls.is_active:

global _sys_stdout_write_hidden

cls.is_active = False

_sys_stdout_write_hidden = _stdout_default.write

pour utiliser ceci, vous pouvez simplement appeler StdErrReplament::lock(logger) et StdOutReplament::lock(logger)

en passant le enregistreur que vous souhaitez utiliser pour envoyer le texte de sortie. Par exemple:

import os

import sys

import logging

current_folder = os.path.dirname( os.path.realpath( __file__ ) )

log_file_path = os.path.join( current_folder, "my_log_file.txt" )

file_handler = logging.FileHandler( log_file_path, 'a' )

file_handler.formatter = logging.Formatter( "%(asctime)s %(name)s %(levelname)s - %(message)s", "%Y-%m-%d %H:%M:%S" )

log = logging.getLogger( __name__ )

log.setLevel( "DEBUG" )

log.addHandler( file_handler )

log.file_handler = file_handler

log.clean_formatter = logging.Formatter( "", "" )

StdOutReplament.lock( log )

StdErrReplament.lock( log )

log.debug( "I am doing usual logging debug..." )

sys.stderr.write( "Tests 1...\n" )

sys.stdout.write( "Tests 2...\n" )

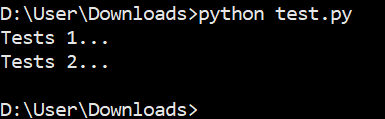

l'Exécution de ce code, vous verrez sur l'écran:

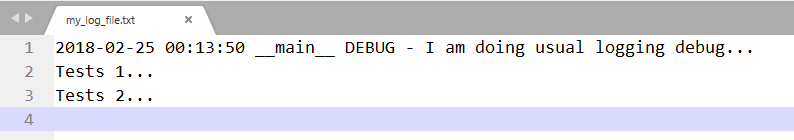

et sur le contenu du fichier:

si vous souhaitez également voir le contenu des appels log.debug à l'écran, vous aurez besoin d'ajouter un flux gestionnaire de votre enregistreur. Sur ce cas, il serait comme ceci:

import os

import sys

import logging

class ContextFilter(logging.Filter):

""" This filter avoids duplicated information to be displayed to the StreamHandler log. """

def filter(self, record):

return not "_duplicated_from_file" in record.__dict__

current_folder = os.path.dirname( os.path.realpath( __file__ ) )

log_file_path = os.path.join( current_folder, "my_log_file.txt" )

stream_handler = logging.StreamHandler()

file_handler = logging.FileHandler( log_file_path, 'a' )

formatter = logging.Formatter( "%(asctime)s %(name)s %(levelname)s - %(message)s", "%Y-%m-%d %H:%M:%S" )

file_handler.formatter = formatter

stream_handler.formatter = formatter

stream_handler.addFilter( ContextFilter() )

log = logging.getLogger( __name__ )

log.setLevel( "DEBUG" )

log.addHandler( file_handler )

log.addHandler( stream_handler )

log.file_handler = file_handler

log.stream_handler = stream_handler

log.clean_formatter = logging.Formatter( "", "" )

StdOutReplament.lock( log )

StdErrReplament.lock( log )

log.debug( "I am doing usual logging debug..." )

sys.stderr.write( "Tests 1...\n" )

sys.stdout.write( "Tests 2...\n" )

qui produirait comme ceci lors de l'exécution:

alors qu'il serait encore sauvegarder ce dans le fichier my_log_file.txt :

lors de la désactivation avec StdErrReplament:unlock() , il ne restaurera que le comportement standard du flux stderr , car l'enregistreur joint ne peut jamais être détaché parce que quelqu'un d'autre peut avoir une référence à sa version plus ancienne. C'est pourquoi c'est un singleton mondial qui ne peut jamais mourir. Par conséquent, en cas de rechargement de ce module avec imp ou quelque chose d'autre, il ne récupérera jamais le sys.stderr courant car il a déjà été injecté sur lui et l'avoir enregistré en interne.